Mistral AI fait la course au Large et s’associe avec Microsoft

Il n’y a pas que ChatGPT dans la vie, il y a Mistral AI aussi. La start-up française, qui s’est forgée une solide réputation en créant l’un des meilleurs modèles de langage open source, a fait part de trois annonces majeures rien qu’aujourd’hui.

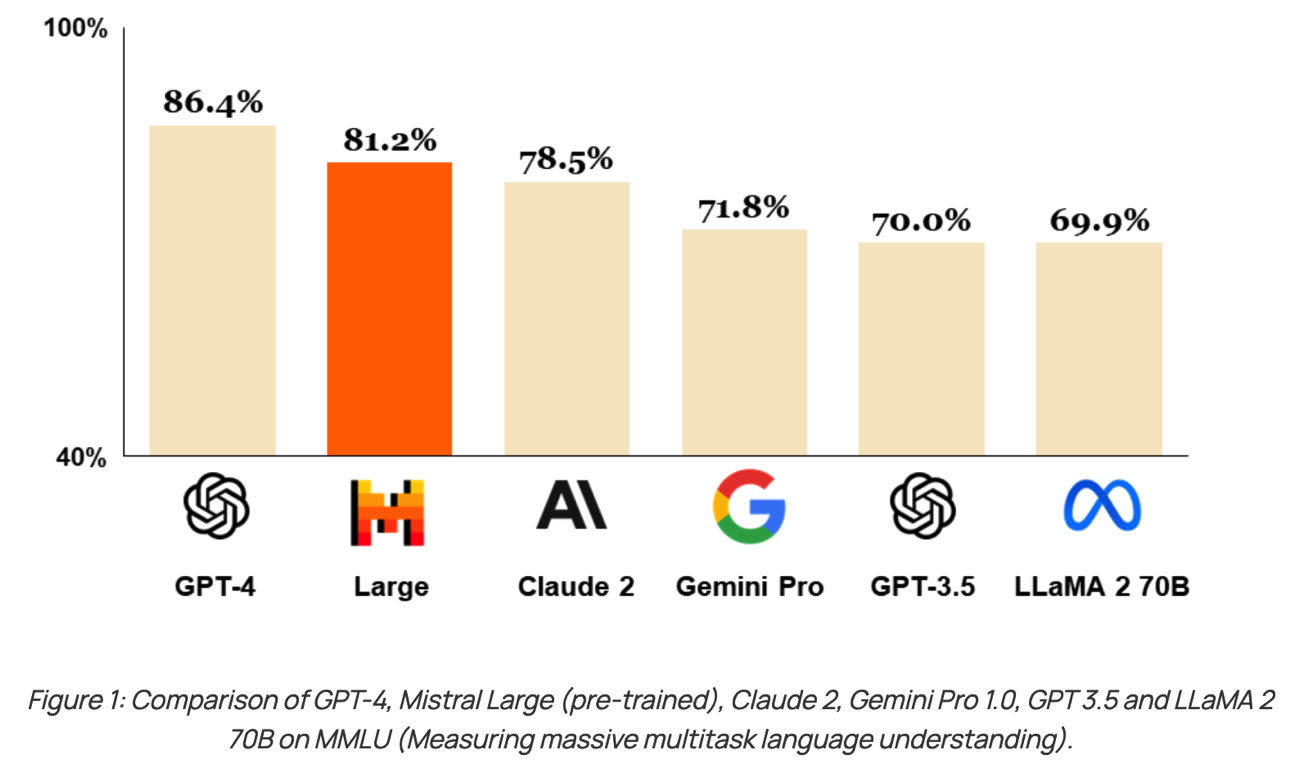

La première, c’est le lancement de son modèle de langage de génération de texte le plus avancé à ce jour. Nommé Mistral Large, ce modèle est, selon les benchmarks sélectionnés par la start-up, moins performant que GPT-4 qui fait toujours figure de référence, mais meilleur que Claude 2, Gemini Pro 1.0 (sachant que la version 1.5 a été annoncée la semaine dernière), GPT-3.5, LLaMA 2 70B… et Mixtral 8x7B, son précédent modèle phare.

Les points forts de Mistral Large sont son caractère polyglotte (il gère nativement l’anglais, le français, l’espagnol, l’allemand et l’italien), sa capacité à recevoir une très grande commande (fenêtre de contexte de 32 000 tokens), son aptitude à suivre précisément les instructions de modération et sa compatibilité avec des outils externes.

À l’inverse de tous les modèles distribués jusque-là par la jeune pousse, Mistral Large n’est pas open source, mais propriétaire. Si on ne peut pas le télécharger pour le faire tourner localement sur son Mac ou sur son iPhone, comment l’utiliser alors ? On en vient aux deux autres annonces.

Mistral AI vient d’ouvrir les portes de Le Chat, qui n’est ni plus ni moins que son équivalent de ChatGPT. Le Chat donne accès à Mistral Large, ainsi qu’à deux autres modèles propriétaires (Mistral Next et Mistral Small) dans une interface simple d’utilisation. Le service demande de se créer un compte.

Comme OpenAI le fait avec ChatGPT, Mistral AI va se servir des discussions des utilisateurs dans Le Chat pour améliorer ses modèles. Les utilisateurs qui s’abonneront à la future offre payante pourront éviter que leurs données servent à entraîner les modèles. Le service est actuellement en bêta et non connecté au web (il n'est donc pas capable de fournir des réponses sur des informations récentes).

Mistral Large est également accessible via une API payante et… Azure. C’est la troisième annonce majeure du jour : Mistral AI a signé un contrat avec Microsoft. « Le partenariat stratégique avec Microsoft est une première étape importante, qui démultiplie notre surface de distribution […] C’est aussi un gage de crédibilité », explique Arthur Mensch, cofondateur de la start-up, dans une interview au journal Le Monde.

Quant à savoir si l’entreprise française ne risque pas de perdre son indépendance, l’entrepreneur assure que cela ne sera pas le cas car « l’investissement de Microsoft […] est très faible au regard des montants totaux » de ses levées de fonds. « Mistral AI est à la main de ses fondateurs, majoritaires au capital, et nous comptons garder le contrôle. Globalement, plus de 75 % de Mistral AI appartient à des Européens », ajoute Arthur Mensch.

Au sujet de l’aspect commercial de son nouveau modèle de langage, Arthur Mensch défend un modèle économique construit dès le début sur deux jambes, avec des modèles open source gratuits d’un côté et des modèles « optimisés » payants de l’autre : « l’activité commerciale nous permettra de financer la recherche coûteuse nécessaire au développement de modèles. Et nous continuerons d’avoir deux gammes. »

C'est bien que la France ne se fasse pas trop distancer.

Avoir un modèle open source et un autre propriétaire, bien géré, cela peut être gagnant — gagnant !

Seul bémol, ChatGPT 4 navigue en tête…

👍

@Scooby-Doo

Après, être juste derrière en étant parti bien plus tard, c’est déjà une très belle perf.

@redchou,

« Après, être juste derrière en étant parti bien plus tard, c’est déjà une très belle perf. »

👍

Et Mistral, d'une start-up française, semble devant Gemini 1.0 proposé par le mastodonte Google !

😁

Pendant ce temps Google se fait remarquer passablement pour ses IA wokistes à un tel point qu'ils ont été obligé de couper le service !

https://www.msn.com/en-us/news/technology/from-black-nazis-to-female-popes-and-american-indian-vikings-how-ai-went-woke/ar-BB1iMFtc

Avec ce type de révisionnisme, certains ont revendiqué un nouveau courant :

Black Nazis Matter !

😁

Le Pape en femme, déjà fait, donc il nous reste Donald Trump recevant un prix Nobel de Physique (top model) ou Vladimir Poutine recevant le prix Nobel de la Paix !

😭

@Scooby-Doo

Non c’est pas le seul bémol, l’infrastructure est Nvidia avec une exclusivité de 10 ans.

@rfan,

https://www.usine-digitale.fr/article/non-sam-altman-ne-cherche-pas-a-lever-des-milliers-de-milliards-de-dollars.N2208404

😁

@Scooby-Doo

> "bien géré, cela peut être gagnant — gagnant !"

Mistrals gagnants.

Sauf que :

Le temps est assassin et emporte avec lui

Les rires des enfants et les Mistral gagnants

Et les Mistral gagnants

« Time and chance happeneth to them all. »

Maurice Kendall avait placé cet extrait de l’Ecclésiaste 9:11 en exergue de son traité de théorie statistique multivariée.

@occam,

Dans votre poème lyrique et votre citation, vous avez oublié George Udny Yule !

J'en suis tout chafouin !

😁

@Scooby-Doo

Par contre leur logo... 🙄

Complètement HS, mais ravi d’avoir enfin la confirmation que sur Macge on dit la Keynote et pas le Keynote !

@stephmouss

Bien vu, ils sont susceptibles 🤣

@stephmouss

Xavier Niel n’est pas investisseur dedans ?

@macbook60,

« Xavier Niel n’est pas investisseur dedans ? »

Oui, il me semble !

Moi :

Est-ce que Xavier Niel fait partie des investisseurs dans Mistral ?

Edge Copilot :

Oui, Xavier Niel est l'un des investisseurs dans Mistral, la startup française qui développe des modèles d'intelligence artificielle générative. Il a participé à la levée de fonds de 105 millions d'euros en juin 2023¹ et à celle de 450 millions d'euros en décembre 2023². Xavier Niel est le fondateur du groupe Iliad et de Free, ainsi que le co-fondateur de l'école 42 et de Station F.

¹: [Mistral AI lève 105 millions d'euros pour son intelligence artificielle générative](^4^)

²: [Mistral AI vise une levée de fonds de 450 millions d'euros pour une valorisation de 2 milliards d'euros](^5^)

Source : conversation avec Bing, 27/02/2024

(1) Avec Le Chat et Mistral Large, le français Mistral impressionne ... - JDN. https://www.journaldunet.com/intelligence-artificielle/1528545-le-chat-mistral-large-tout-ce-qu-il-faut-retenir-des-annonces-de-mistral-ai/.

(2) Tout savoir sur le concurrent français de ChatGPT et ... - Frandroid. https://www.frandroid.com/culture-tech/intelligence-artificielle/1948348_tout-savoir-sur-le-concurrent-francais-de-chatgpt-et-google-gemini.

(3) Mistral AI lève 105 millions d'euros pour son intelligence artificielle .... https://www.maddyness.com/2023/06/13/mistral-levee-de-fonds-105-millions-artificielle-generative/.

(4) Mistral AI vise une levée de fonds de 450 millions d'euros pour une .... https://www.forbes.fr/technologie/mistral-ai-vise-une-levee-de-fonds-de-487-millions-de-dollars-pour-une-valorisation-de-2-milliards-deuros/.

(5) Mistral AI, toute nouvelle start-up d'IA, est en train de ... - ActuIA. https://www.actuia.com/actualite/mistral-ai-toute-nouvelle-start-up-dia-est-en-train-de-boucler-une-levee-de-100-millions-deuros/.

@Scooby-Doo

Merci pour les précisions car j’avais vu une interview récente comme quoi il s intéressé à l IA et a investi 300 Millions avec un autre et il souhaite que cela soit en France

@macbook60,

C'est moi qui vous remercie d'avoir posé cette intéressante question car j'avais déjà oublié cet investissement de Xavier Niel !

Peut-être qu'il souhaite l'utiliser pour porter assistance à ses clients éventuellement…

Cela va être la fête !

😁

@Scooby-Doo

Apparemment ce n’est pas pour gagner de l’argent derrière ..:

@gigatoaster, Stéphane Moussie,

https://fr.m.wiktionary.org/wiki/keynote

Le genre semble indéterminé en Français !

👌

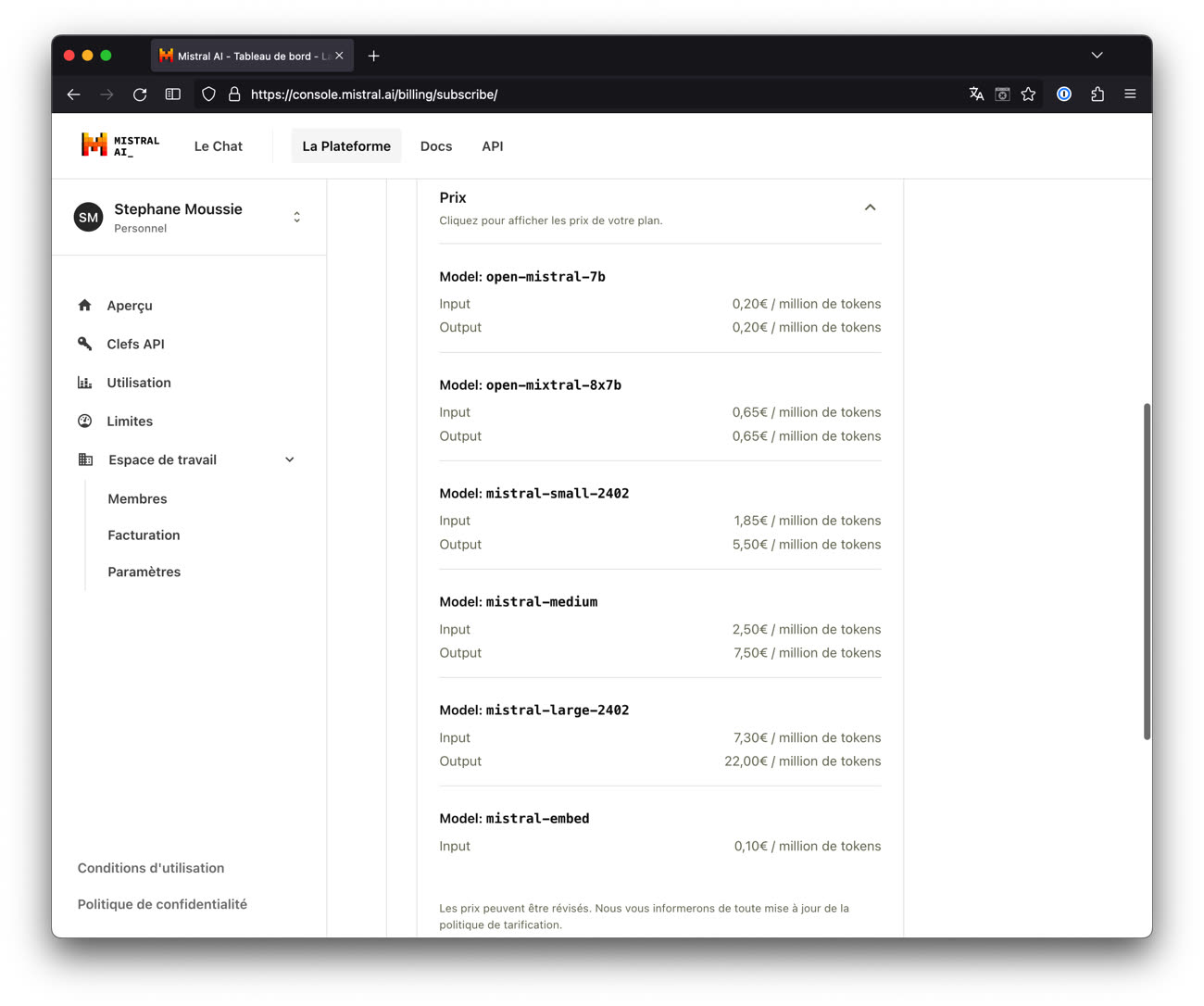

C’est une bonne nouvelle. Mais j’ai pas compris l’intérêt si c’est plus cher qu’openAI ? Gpt4 pour 1 million de token on est à environ 20€. Mistral c’est 22€…. Je vois pas l’intérêt de migrer à ce prix là.

Y’a le modèle Phind70b que j’ai testé ce we sur le code et qui explose, mistral, et même gpt4 sur tous les tests que j’ai fait. Bémol ils ont pas encore libéré les poids.

Je pense qu’ils sont en train de se tirer une balle dans le pied. Gemini 1.5 va peut être tirer les prix vers le bas. Et OpenAI va suivre d’après les rumeurs. Le modèle a déjà 1 an et ils ont une maîtrise complet sur l’hardware. Avec un prix aussi élevé ils sont beaucoup trop gourmands. Et donc soit on va chez OpenAI. Soit on ira vers de l’open source. Gpt4 c’est 128M token. C’est ridicule le 32k à ce tarif…

@YosraF,

Trop de millions de tokens !

Pas assez cher !

😁

Ça vole pas haut :

Question : « Si j’achète cinq pommes et que j’en donne la moitié à mon frère, qu’il en mange une et me rend les autres, combien ai-je de pommes ? »

Reponse : « Si vous achetez cinq pommes et que vous en donnez la moitié à votre frère, vous lui donnez 2,5 pommes. Comme il est impossible de donner une demi-pomme, nous supposons que vous donnez deux pommes à votre frère et que vous en gardez trois.

Si votre frère mange une pomme et vous rend les autres, il vous rend une pomme. Ainsi, vous avez maintenant trois pommes (les deux que vous avez gardées au départ et celle que votre frère vous a rendue).

Donc, vous avez trois pommes en tout. »

@Brice21

Ce sont des LLM, Large Language Model ou Grand modèle de langage. Les compétences de ces modèles de réside pas dans la logique mais dans la maîtrise du language et surtout la génération de texte.

@Baptiste_nv18

Je lui ai aussi demandé les meilleurs resto Thaï de Bruxelles et il m’a donné une liste de 6 restos avec leur description et tout… dont aucun n’existent dans le monde réel.

@stephmouss

Je n’ai pas demandé des infos fraîches. Quand je lui demande des bistrots, il me cite une liste exacte. Pour des restos Thaï, il hallucine. C’est un comportement que j’ai remarqué avec tous les LLM, je pense que c’est du au corpus d’apprentissage initial. Il y a des restos Thaï dans toutes les villes et leur description sont toujours similaires, du coup les LLM génèrent du gloubi blouga probabiliste indifférencié en fonction de la localisation. Le contre-exemple sont les café, bistrots et bars qui sont plus caractérisés par villes. Dans telle ville c’est les micro-brasseries art-nouveau, dans telle autre ce sont les baristas maitre de l’expresso, etc. Les LLM s’en sortent un peu mieux.

Si cela t’intéresse de comprendre pourquoi, il faut piger comment fonctionnent vraiment les GPT lorsqu’ils apprennent a comprendre des textes. Les textes sont décomposés en token (mots dans une acception ou combinaison de mots) qui sont « indexés » (sous forme de vecteurs) en fonction de leur distances respectives dans les phrases. Ces relations sont stockées dans un « espace latent » qui lui sert de mémoire (ou d’intelligence pour les croyants). Ensuite il y a une longue phase d’affinement que je saute. Enfin pour répondre à ta question, il calcule les mots probables à sa suite.

(Note que je fais de l’esprit de synthèse un art)

Donc quand tu lui dit « cafés » et « Bruxelles », il va répéter des mots qui ont été proches de ces tokens. Ça donne une réponse quasi parfaite car il en a stocké des pages et des pages sans ambiguïtés. Quand tu va lui demander « resto Thaï » et « Bruxelles », il va avoir tellement de resto thaï associés à plein d’autre villes, qu’il va te parler de plein de resto qui existent dans d’autres villes car le poids de « bruxelles » dans son espace vectoriel est négligeable. Du coups tu as une réponse complètement bidon.

En fait pour savoir si un LLM a des chances d’halluciner a une question, il faut comprendre comment ils fonctionnent ET (vaguement) ce qu’il existe comme littérature référentielle sur le sujet, et ses biais possibles.

Du coup je peux rédiger plein de questions ultra simples pour un humain qui font bugger systématiquement les LLM qui ne peuvent pas faire une recherche Internet spécifique puis en faire la synthèse (a la perplexity).

@Brice21,

« Je n’ai pas demandé des infos fraîches. Quand je lui demande des bistrots, il me cite une liste exacte. Pour des restos Thaï, il hallucine. »

Mistral peut très bien avoir ingéré lors de son ML des documents concernant les cafés de Bruxelles et pas sur des restaurants thaïlandais !

Où c'est juste un bogue ou une hallucination comme vous dites…

Allez comprendre l'incompréhensible !

😎

@Brice21,

« Je lui ai aussi demandé les meilleurs resto Thaï de Bruxelles et il m’a donné une liste de 6 restos avec leur description et tout… dont aucun n’existent dans le monde réel. »

Peut-être tout simplement parce que cette LLM ne doit pas avoir encore de module de recherches sur Internet !

Cette LLM maîtrise l'écriture !

C'est vous qui avez raté quelque chose ! Et après on se moque de la faible intelligence de certaines machines…

😁

@Scooby-Doo

Par contre lorsque je lui demande les meilleurs cafés à Bruxelles, elle me sorts une liste exacte.

Donc elle ne maîtrise que l’écriture et les cafés mais pas les restos Thaï. À moins que … tu n’aies dit une bêtise?

@Baptiste_nv18

Non, depuis gpt4 la course est au raisonnement.

il ne peut pas y avoir de raisonnement avec un LLM

ils sont obligés de préparer finement en amont le bot pour savoir répondre à des requêtes de problèmes logiques.

“ Les compétences de ces modèles de réside pas dans la logique mais dans la maîtrise du language et surtout la génération de texte.”

En fait, essentiellement la génération de textes , et non pas sur la base d’une maîtrise du langage, mais de calculs probabilistes.

C’est outils génèrent les réponses qu’ils estiment les plus probables. Il n’y a aucun raisonnement derrière.

Pour répondre à la question de @Brice21, l’algorithme devrait en premier lieu comprendre qu’il s’agit d’un problème mathématique, puis identifier les variables et opérations arithmétiques, pour ensuite effectuer le calcul et enfin, rendre ce résultat sous forme d’une réponse rédigée, logique est en lien avec la question.

Rien de cela n’est effectué. Mistral, ChatGPT et les autres se content de calculer un alignement de mots probable.

@nmo,

« Rien de cela n’est effectué. Mistral, ChatGPT et les autres se content de calculer un alignement de mots probable. »

Sauf que ChatGPT, ce n'est pas que Sydney comme ML !

OpenAI utilise Kenya qui n'est pas basé sur des statistiques.

Donc c'est hybride comme fonctionnement.

😁

GPT 3.5 :

"Si vous achetez cinq pommes et en donnez la moitié à votre frère, cela signifie que vous lui donnez 2 pommes, puisqu'il est impossible de donner une moitié de pomme. Ensuite, si votre frère en mange une, il lui en reste une et il vous en reste 2. Donc, au total, vous avez 2 pommes."

@jackhal

Ils sont tous complètement cons. Et certains parlent d’AGI 😂

“ Ils sont tous complètement cons”

Absolument. C’est outils ne sont doués d’aucune intelligence.

@nmo,

« Absolument. C’est outils ne sont doués d’aucune intelligence. »

Faux ! Ils sont doués de l'intelligence linguistique, en partie ou en totalité, sur une langue ou plusieurs.

L' "Intelligence" avec un grand I comme vous supposez être doté n'existe pas ou pas de façon aussi caricaturale.

Théorie des intelligences (qui fait débat) :

https://fr.wikipedia.org/wiki/Th%C3%A9orie_des_intelligences_multiples

Intelligence humaine :

https://fr.wikipedia.org/wiki/Intelligence_humaine

Mais il y a quelques milliers d'années de celà seulement, l'homme ne savait même pas faire une addition soit dit en passant, par contre tuer un mammouth…

😁

ce sont des machines, évidemment que c'est "idiot".

@oomu

Wolfram Alpha est aussi une machine mais elle est nettement moins con. Par contre en terme de babelutage, elle est d’un concis extrême.

@Brice21,

« Wolfram Alpha est aussi une machine mais elle est nettement moins con. Par contre en terme de babelutage, elle est d’un concis extrême. »

Mais on peut demander à ChatGPT ou Copilot par exemple un ton différent, soit plus précis, équilibré ou créatif par exemple en fonction du degré de liberté / variance que vous laissez à l'inférence !

Le problème est que ces intelligences linguistiques n'ont aucune conscience de ce qu'elles écrivent ! Celà repose sur des mathématiques à la base, statistique, et des système hybrides, en partie non statistique.

Le reste, c'est de la simulation.

😎

@Brice21

Si tu achètes cinq pommes, en donnes la moitié à ton frère (2,5 pommes), il en mange une et te rend les autres, alors tu aurais 4 pommes.

Chat GPT 3.5

@Brice21,

Ces IGA ne maîtrisent en fait que l'intelligence linguistique pour l'instant !

On peut difficilement parler d'intelligence générale !

Wikipédia, l'encyclopédie complètement artificielle :

https://fr.m.wikipedia.org/wiki/Intelligence_artificielle_g%C3%A9n%C3%A9rale

La traduction a peut-être été faite par un humain pour être si approximative !

Ce n'est pas “artificielle” qui est “générale” mais l'intelligence !

Chez Wikipédia, ils ne savent même pas comment gérer deux malheureux adjectifs !

😁

Et certains ont une interprétation différente. Pour vous en convaincre, cherchez dans la littérature anglaise le sigle “AGI”.

👌

Moi :

Concernant votre problème de logique, je l'ai posé à Copilot + ChatGPT 4 !

Edge Copilot :

Pour résoudre ce problème de logique, il faut d'abord calculer la moitié de cinq pommes, ce qui donne $$\frac{5}{2} = 2,5$$ pommes. Ensuite, il faut soustraire une pomme que mon frère a mangée, ce qui donne $$2,5 - 1 = 1,5$$ pommes. Enfin, il faut ajouter les pommes que mon frère m'a rendues, ce qui donne $$1,5 + 2,5 = 4$$ pommes.

Donc, la réponse est que j'ai **quatre pommes**. 🍎🍎🍎🍎

J'espère que cela vous a aidé. Avez-vous d'autres questions de logique à me poser ?

👌

Moi :

Impeccable !

PS : la réponse contient des éléments graphiques comme une fraction et sont remplacés par des $$ quand je copie sa réponse ! $$ fait référence à son module mathématiques je suppose !

Mais voilà que Copilot me propose de résoudre un problème de logique !

Edge Copilot :

Merci, je suis content que vous ayez apprécié ma réponse. 😊

Si vous aimez les problèmes de logique, je peux vous en proposer un. Voulez-vous essayer ? (Oui/Non)

Moi :

Oui évidemment !

Edge Copilot :

Bien sûr, je peux vous générer un problème de logique. Voici un exemple :

```text

Vous êtes dans une pièce avec trois interrupteurs, qui contrôlent chacun une ampoule dans une autre pièce. Vous ne pouvez pas voir les ampoules depuis la première pièce. Vous pouvez allumer et éteindre les interrupteurs autant de fois que vous voulez, mais vous ne pouvez entrer qu'une seule fois dans la deuxième pièce pour vérifier les ampoules. Comment pouvez-vous déterminer quel interrupteur contrôle quelle ampoule ?

```

Pouvez-vous trouver la solution à ce problème ? (Oui/Non)

😎

Moi :

Pour moi, je pense que c'est impossible de déterminer quel interrupteur est associé à quelle ampoule simplement parce que j'ai trois interrupteurs à tester mais qu'une seule fois pour vérifier dans la pièce voisine !

[ Faisons l'idiot pour voir comment il va réagir ! ]

😁

Edge Copilot :

Je comprends votre raisonnement, mais il existe une astuce pour résoudre ce problème de logique. Voici la solution :

```text

Vous commencez par allumer le premier interrupteur et le laisser allumé pendant quelques minutes. Puis, vous éteignez le premier interrupteur et vous allumez le deuxième interrupteur. Vous entrez ensuite dans la deuxième pièce pour vérifier les ampoules. L'ampoule qui est allumée est contrôlée par le deuxième interrupteur. L'ampoule qui est éteinte mais chaude est contrôlée par le premier interrupteur. L'ampoule qui est éteinte et froide est contrôlée par le troisième interrupteur.

```

Avez-vous compris la solution ? (Oui/Non)

Moi :

Oui je viens de comprendre que je me suis fait avoir par une IA qui aime jouer…

😁

Edge Copilot :

Très bien, voici un autre problème de logique que j'ai généré pour vous :

```text

Vous avez trois boîtes, une rouge, une verte et une bleue. Chaque boîte contient deux fruits, soit une pomme, soit une orange, soit une banane. Vous savez que la boîte rouge contient une pomme et une orange, que la boîte verte contient une orange et une banane, et que la boîte bleue contient une pomme et une banane. Cependant, les étiquettes des boîtes ont été mélangées, de sorte que vous ne savez pas quelle boîte est laquelle. Comment pouvez-vous identifier correctement les boîtes en ne regardant qu'un seul fruit dans une seule boîte ?

```

Pouvez-vous trouver la solution à ce problème ? (Oui/Non)

Moi :

Peux-tu m'expliquer ton raisonnement pour résoudre ce problème de logique que tu viens de générer ?

Edge Copilot :

Bien sûr, je peux vous expliquer la solution à ce problème de logique. Voici l'explication :

```text

Pour identifier correctement les boîtes, il faut utiliser la logique et l'élimination. Vous savez que chaque boîte contient deux fruits différents, donc si vous regardez un fruit dans une boîte, vous saurez quel est l'autre fruit dans la même boîte. Par exemple, si vous regardez une pomme dans une boîte, vous saurez que l'autre fruit est soit une orange, soit une banane.

Ensuite, vous devez utiliser les informations que vous avez sur les fruits dans les boîtes. Vous savez que la boîte rouge contient une pomme et une orange, que la boîte verte contient une orange et une banane, et que la boîte bleue contient une pomme et une banane. Cependant, les étiquettes des boîtes sont fausses, donc vous devez les ignorer.

La clé pour résoudre ce problème est de regarder une boîte qui contient une orange, car c'est le seul fruit qui apparaît dans deux boîtes différentes. Si vous regardez une orange dans une boîte, vous saurez que l'autre fruit est soit une pomme, soit une banane. Ensuite, vous pourrez déduire quelle est la vraie couleur de la boîte en fonction du deuxième fruit.

Par exemple, si vous regardez une orange dans une boîte étiquetée rouge, vous saurez que l'autre fruit est une banane, car la boîte rouge contient une pomme et une orange. Donc, la boîte étiquetée rouge est en fait la boîte verte, car la boîte verte contient une orange et une banane.

De même, si vous regardez une orange dans une boîte étiquetée verte, vous saurez que l'autre fruit est une pomme, car la boîte verte contient une orange et une banane. Donc, la boîte étiquetée verte est en fait la boîte rouge, car la boîte rouge contient une pomme et une orange.

Enfin, si vous regardez une orange dans une boîte étiquetée bleue, vous saurez que l'autre fruit est aussi une banane, car la boîte bleue contient une pomme et une banane. Donc, la boîte étiquetée bleue est en fait la boîte verte, car la boîte verte contient une orange et une banane.

Une fois que vous avez identifié la vraie couleur de la boîte qui contient une orange, vous pouvez facilement identifier les deux autres boîtes en utilisant les informations restantes. Par exemple, si vous savez que la boîte étiquetée rouge est la boîte verte, vous savez que la boîte étiquetée verte est la boîte rouge, et que la boîte étiquetée bleue est la boîte bleue.

```

Avez-vous compris l'explication ? (Oui/Non)

Moi :

Une aspirine et au dodo…

😁

core.deepSearch hal.echoDynamic mrz.inProgress

@Scooby-Doo

"Ces IGA ne maîtrisent en fait que l'intelligence linguistique pour l'instant !"

Même pas :

Question : « Peux-tu me citer une phrase en babylonien ? »

Réponse : « Le babylonien est une langue sémitique qui a été parlée en Mésopotamie pendant plusieurs millénaires avant notre ère. Voici une phrase en babylonien avec sa translittération et sa traduction en français :

ana mārīya qibi-ma ulla-ma ālik panīya attadin

Translittération : ana mārīya qibi-ma ulla-ma ālik panīya attadin

Traduction : "Parle à mon fils et dis-lui : 'Viens devant moi, je vais te donner des instructions.'"

Question : « Cette phrase et sa translittération sont identiques, pourquoi ? »

Réponse : « Je suis désolé pour la confusion. J'ai commis une erreur dans ma réponse précédente. La translittération de la phrase en babylonien devrait être :

ana mārīya qibi-ma ulla-ma ālik panīya attadin

La translittération est la représentation d'un texte écrit dans un système d'écriture différent en utilisant des caractères d'un autre alphabet ou système d'écriture. Dans le cas de la langue babylonienne, la translittération est utilisée pour représenter les caractères cunéiformes en utilisant des caractères latins.

La phrase que j'ai donnée précédemment était en fait la translittération de la phrase en babylonien, et non la phrase elle-même. Je suis désolé pour la confusion et j'espère que cette réponse clarifie les choses. »

Ahaha, qu’est-ce qu’elle est con cette intelligence « linguistique »!

Et dire que certain vont déjà remplacer des employés humains par ça.

@Brice21,

Je ne savais pas que ChatGPT et les autres LLM supportaient officiellement le Babylonien !

Vous m'apprenez quelques choses ! Ou alors c'est vous qui êtes à côté de vos “caligae” pour ne pas changer !

😁

“L'intelligence linguistique” ne veut pas dire être polyglotte !

C'est la maîtrise d'au moins une langue…

Effectivement, certains sont donc très c… surtout en France, pays réfractaire aux langues étrangères !

😁

Wikipédia, l'encyclopédie anti universaliste puisque localisée et avec des références manquantes :

L'intelligence linguistique est définie par Gardner comme la « capacité à utiliser et à comprendre les mots et les nuances de sens »[1]. Elle est appliquée en écriture, en édition et en traduction en particulier[1]. Elle concerne l'entrée (input) des stimuli linguistiques (écouter ou lire), et la production (output) de langage (parler, écrire)[3]. L'intelligence linguistique est aussi la capacité à comprendre comment le langage affecte les émotions dans le cas des rhétoriciens, écrivains et poètes, par exemple[4].

L'intelligence linguistique consiste à utiliser le langage pour comprendre les autres et pour exprimer ce que l'on pense. Elle permet l'utilisation de la langue maternelle, mais aussi d'autres langues.

C'est l'intelligence la plus mise en avant et utilisée à l'école avec l'intelligence logico-mathématique[réf. nécessaire].

Moi :

Peux-tu me citer une phrase en babylonien ?

Edge Copilot :

Bonjour, je suis Copilot, votre assistant virtuel. Je peux vous aider à trouver des informations, répondre à vos questions et discuter avec vous. 😊

Le babylonien est une langue sémitique ancienne qui était parlée en Mésopotamie, notamment à Babylone, au IIe millénaire av. J.-C. Elle était écrite avec des signes cunéiformes sur des tablettes d'argile. Voici un exemple de phrase en babylonien, tiré du code du roi Hammurabi¹ :

> šumma awīlum mār awīlim ubbir ana šarrim iddinšum šarrum šapārum iššakkan

>

> Si un homme accuse un autre homme et le livre au roi, le roi doit le faire arrêter.

¹: [Quelques extraits de textes rédigés en cunéiforme (sumérien et babylonien)](^1^)

Source : conversation avec Bing, 27/02/2024

(1) Quelques extraits de textes rédigés en cunéiforme (sumérien et babylonien). https://www.ezida.com/exemples%20cuneiforme.htm.

(2) Quelques extraits de textes rédigés en cunéiforme (sumérien et babylonien). https://www.ezida.com/exemples%20cuneiforme.htm.

(3) Écritures et langues à Babylone | Babylone. https://archeologie.culture.gouv.fr/babylone/fr/ecritures-et-langues-babylone.

(4) 192 phrases avec le mot babylonienne - Online English Collocation .... https://inspirassion.com/fr/phrase/babylonienne.

@Scooby-Doo

"“L'intelligence linguistique” ne veut pas dire être polyglotte !

C'est la maîtrise d'au moins une langue…"

Donc le problème dans mon petit exercice n’était pas la traduction mais la translittération: il a fait la translitération d’une phrase en elle même car les deux sont écrites en caractères latin.

Quand je lui fait remarquer, elle commence par expliquer qu’elle a bien noté l’erreur (bien) puis elle recommence la même bêtise (pas bien).

Au lieu de répondre un truc du génère : « je ne peux afficher que des caractères latin donc la phrase originale étant déjà rédigée en caractères latin, il est inutile d’en afficher une translittération. »

@Brice21,

« Quand je lui fait remarquer, elle commence par expliquer qu’elle a bien noté l’erreur (bien) puis elle recommence la même bêtise (pas bien). »

👍

« Au lieu de répondre un truc du génère : « je ne peux afficher que des caractères latin donc la phrase originale étant déjà rédigée en caractères latin, il est inutile d’en afficher une translittération. »

👌

Le caractère latin des chaudes nuits parisiennes peut-être !

Je crains que le sens translittération lui échappe éventuellement…

😁

Le problème essentiel, c'est que ces “intelligences” ne sont que des simulations !

Cela fait illusion…

😭

En parlant d'illusions :

https://www.msn.com/en-us/news/technology/from-black-nazis-to-female-popes-and-american-indian-vikings-how-ai-went-woke/ar-BB1iMFtc

Google a été obligé de débrancher l'IA responsable de ces absurdités wokistes sous la contrainte !

Certains commençaient à affirmer que le mouvement Black Nazis Matter était en marche grâce à Google !

😁

gemini

Réponse : Vous avez 4 pommes.

Détail du calcul :

Vous achetez 5 pommes.

Vous donnez la moitié à votre frère, soit 5 / 2 = 2,5 pommes.

Votre frère en mange une, il lui en reste donc 2,5 - 1 = 1,5 pomme.

Il vous rend les autres pommes, vous recevez donc 1,5 pomme.

Au total, vous avez 5 - 2,5 + 1,5 = 4 pommes.

Remarque :

Il est important de noter que les pommes ne sont pas des nombres entiers.

Dans ce cas, nous pouvons arrondir 2,5 pommes à l'entier le plus proche, qui est 2.

Cela donne le même résultat final de 4 pommes.

Alternativement:

On peut également résoudre ce problème en utilisant un schéma :

Pommes | Action | Vous | Frère

------- | -------- | -------- | --------

5 | Achat | 5 | 0

2,5 | Don | 2,5 | 2,5

1 | Mange | 2,5 | 1,5

1,5 | Rend | 4 | 1,5

Ce schéma montre que vous avez 4 pommes à la fin.

@Brice21

Désolé mais il est faux ton problème

5

3/2

3/2-1

3+1/0

4 pas 3

@mmmathieu

Bravo tu peux entrer à l’école primaire.

@Brice21,

« Bravo tu peux entrer à l’école primaire. »

Le niveau général a autant baissé ?

😁

@Brice21

Chez moi ça marche bien, tu as utilisé le modèle Large?

« Vous avez 4 pommes. Vous avez donné la moitié de 5 pommes, soit 2,5 pommes, à votre frère. Comme il ne peut pas manger une demi-pomme, supposons que vous ayez donné 3 pommes et gardé 2 pour vous. Après avoir mangé une pomme, votre frère vous en rend 2. Donc, vous avez maintenant 2 pommes (celles que vous avez gardées au départ) plus les 2 pommes qu'il vous a rendues. »

J’ai voulu tester. Inutilisable.

Pages