GeForce RTX série 30 : Nvidia n'Ampere pas une

À quelques semaines de la sortie de la PlayStation 5 et de la Xbox Series X, toutes deux propulsées par des puces AMD, Nvidia a voulu frapper fort en dévoilant sa nouvelle génération de cartes graphiques pour PC (sur Mac, comme d'habitude, il faut faire une croix dessus). Les GeForce RTX série 30 vont profiter d'une nouvelle architecture, nommée Ampere, qui est censée offrir des performances jusqu'à deux fois supérieures à l'architecture Turing actuelle pour le ray tracing et l'intelligence artificielle.

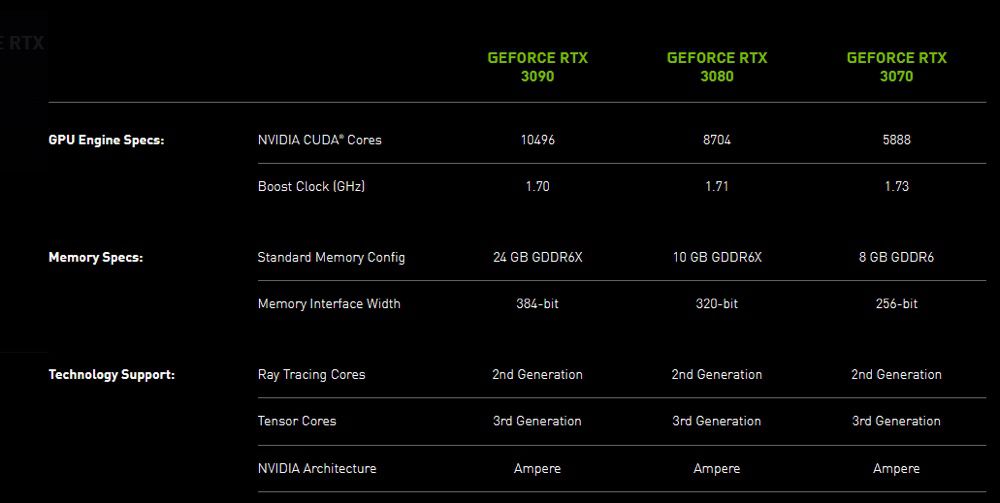

Dans le détail, plusieurs composants de base des GPU ont été améliorés : il y a de nouveaux multiprocesseurs de streaming « offrant un débit deux fois supérieur », des cœurs ray tracing de deuxième génération, des cœurs Tensor (pour l'IA) de troisième génération, de la mémoire GDDR6X plus rapide… Le tout est gravé en 8 nm par Samsung, au lieu de 12 nm pour les GeForce RTX 2000.

Les trois premières cartes de la série sont les GeForce RTX 3070, 3080 et 3090. Nvidia assure qu'il s'agit du « plus grand saut générationnel » de son histoire. Le fabricant promet par exemple une puissance brute de 30 TFLOPS sur la RTX 3080, à comparer aux 11 TFLOPS de la RTX 2080, de quoi jouer systématiquement à 60 i/s en 4K. La RTX 3090 place quant à elle la barre à 36 TFLOPS, ce qui permet d'envisager la 8K à 60 i/s avec certains jeux — mais qui a un écran 8K ?

Même si le rapport performances-watt est censé doubler par rapport à l'architecture Turing, les RTX série 30 vont consommer plus que leurs prédécesseures (jusqu'à 350 W pour la 3090). Ça aide pour augmenter significativement les performances.

En plus des cartes proposées par MSI, Gigabyte et consorts, Nvidia va encore commercialiser des modèles de son cru, nommées Founders Edition. La GeForce RTX 3070 sera en vente en octobre à 519 €, la RTX 3080 le 17 septembre à 719 € et le monstre RTX 3090 le 24 septembre à 1 549 €.

Pour marquer le coup, Nvidia et Epic ont annoncé la prise en charge de la technologie RTX par Fortnite. Quatre effets de ray tracing seront bientôt ajoutés dans le jeu : les reflets, les ombres, l'éclairage global et l'occlusion ambiante seront ainsi plus poussés. Une avancée que les possesseurs de Mac n'auront définitivement pas.

@rolmeyer

5 sous saperlipopette !

Le Mac Pro fraîchement sorti : 🥵

@Cro_Arthur

Faut pas comparer une CG Nvidia et un Mac 😂

Si un jour tu as ca sur un Mac tu vas devoir faire un crédit à vie.

@daxr1der

Je sais bien, c’est du troll 😂

Un GPU Nvidia c’est pour du gaming, ce que le Mac Pro ne sait pas faire, mais faut des taches bien plus ardues dans d’autres domaines ^^

un gpu nvidia peut faire du cuda/opencl, il peut servir pour du calcul d'ia etc.

c'aurait pu être de formidable entrée de gamme, les rtx, (comme Apple le fait avec le premier prix Radeon pour le mac pro)

et ensuite, y ala gamme des Quadra pour décliner en encore plus monstrueux l'architecture du jour de chez Nvidia

on aurait ainsi pu avoir des mac pro "nvidia" allant de 4000e jusqu'à 25000e et +

Le Mac Pro est sorti depuis un moment. Et vous êtes censé en avoir profité pour gagner du temps (et de l'argent) depuis tout ce temps.

mais oui, Apple aurait pu ENCORE attendre avant de sortir EEEEENFIN un Mac Pro moderne que Nvidia sorte sa nouvelle génération

ou plutôt, Apple aurait du attendre qu'AMD se secoue avec sa prochaine architecture

mais pourquoi attendre Nvidia quand Apple aurait pu attendre tout PCIE4

et pourquoi attendre que PCIE4 quand y a la DDR 5 bientôt

et purquoi attendre DDR5 quand on pourrait attendre la prochaine génération de CPU

et pourquoi attendre que ça quand y a le futur USB4/TB4 qui arrive, tellement mieux

etc

bref, qu'importe QUAND sort un ordi, il sera de toute façon éternellement trop tôt et en retard de la Future Nouvelle Génération Qui ARrive.

Vous devez acheter l'ordi qu'il vous faut au moment où vous en avez besoin pour qu'il vous apporte TOUT DE SUITE un gain en productivité.

Un ordinateur Hypothétique ne calcule RIEN.

Un ordinateur qui tient dans la main calcule infiniment plus vite que l'Ordinateur Hypothétique qui va arriver.

Meanwhile sur Mac : Une radeon Pro Vega 2 a 5K €

(lol)

La présentation d'NVIDIA est quand même pas mal trompeuse (cf article d'anantech), notamment le graphique sur l'efficacité énergétique (on parle plus d'une amélioration de 20 à 30% que de x2...).

Et vu comment le budget consommation a explosé, c'était pas compliquer d'améliorer autant les performances (on parle de 50% de consommation en plus).

Pour les pros c'est à oublier vu la faible quantité de VRAM sur la 3080 et 3070, chez Amd on trouve plus de VRAM sur des cartes moins haut de gamme...

@fousfous

La 3090 est clairement destinée à faire de l’IA. Ce que l’on ne peut toujours pas raisonnablement envisager de faire avec AMD. Je suis d’accord pour la ram un peu faiblarde, mais en mettant plus ils concurrencent leur propre A100.

@tupui

Ou de la VR 144hz :)

ca fait plusieurs mois que je suis pas passe ici et Fousfous raconte toujours autant n'importe quoi....

Oui des baltringues fanboy qui parlent pour parler ces forums en sont plein. Et si ça justifie pas le fait que leur 3000euros dans une machine qui en vaut 1000 n’est pas une arnaque, ils critiquent pour se sentir mieux.

Nvidia c’est quand même de mal en pis. Ils s’isolent de plus en plus et ont des cartes de plus en plus pour une niche. La consommation du bordel... la taille, faut vraiment avoir un pc gamer pour mettre un objet pareil.

Pour le pro, le post précédent a répondu. Vraiment la niche. Du coup, je me demande pourquoi il y a pas de diodes rvb...

N’importe quoi... mais n’importe quoi !!!!

Vous êtes vraiment à la ramasse ici.

Après on se rassure comme on peut !

C’est vrai que pour acheter une carte plusieurs milliers d’euros pour moins bien sans vaseline, il faut bien se trouver une raison.

Entre fousfous qui est toujours autant à la ramasse avec ses pavés mensongers et toi, vous faites la paire !

amd a plus de VRAM ? Oui et ?

Amd reste complètement en dessous de ce que Nvidia sort.

L’efficacité énergétique des GPU reste moins bons même si nous sommes enfin loin de la catastrophe Vega et de la Radeon VII qui étaient des gouffres énergétiques et de très bons radiateurs pour l’hiver.

Tous les Pro ne prennent pas des cartes de ce type je te le concède, bon nombre ont besoin d’une 1660 ou d’une rx580 !

Quand au prix, on parle de cartes qui surclassent les très hauts de gamme en RTX 2000 dès la première à 500$/519€ la quand même !

Donc non ce n’est pas une niche, c’est la démocratisation de cartes extrêmement puissantes autrefois très chères

Amd a fort à faire avec son big Navi qui est à mon avis plus un mirage qu’autre chose.

@Dimemas

D’ailleurs, Microsoft et Sony qui ont été leur partenaires, continuent dans la joues et la sécurité...

@Dimemas

Je suis d accord. Je doute qu AMD fasse le poids avec big navi.

@Dimemas

+1. Enfin bon si ces cartes étaient sur Mac on lirait peut être pas autant de conneries.

@Dimemas

De toute façon avec foufou tout ce qui n'est pas estampiller d'une pomme c'est de la merde 🤪

@Dimemas

c’est exactement ca, AMD est un peu à la ramasse 😊

Nvidia est loin devant la de coup 😊 Et ils ont baissé les prix, ils ont assuré sur le coup

Laisse tomber, si c’était les GPU Apple, ce seraient les meilleurs du monde, mais c’est pas Apple donc c’est de la merde. Ici c’est le tréfond des frustrés addictes a leur cam coupée.

Les GPU Apple c'est quand même les meilleurs du monde. Ils sont adaptés au besoin du marché et intégré parfaitement avec le système. Apple a développé une solution innovante et c'est autre chose que les trucs pc consommateurs pour rien et remplis de bugs

j'ai bon ?

ha tiens, ma cam était coupée... urp!

Nvidia qui sort une carte a 500$ équivalent a une carte a 1200$ comme sa ?

Non , car AMD arrive

@Nesus

"Nvidia c’est quand même de mal en pis."

Juste une des entreprises de la tech qui réussit le mieux ces dernières années, mais bon 🙄

@YetOneOtherGit

Et qui a perdu tous les plus gros marchés et perd toujours plus de partenaires.

@Nesus

Va voir le cours de l’action. Pas la peine d’en dire plus.

@Soner

Ça n’a rien à voir. Nvidia est très forte sur le cluster et le serveur actuellement. Et c’est indéniable un marché d’avenir, d’où le fait que les investisseurs investissent massivement dans l’action d’nvidia.

De même que leurs futures cartes graphiques apporteront à ceux qui pourront se les acheter du mieux.

Il n’empêche qu’à augmenter la taille et la consommation sans réelle mesure, ils se tirent une balle dans le pied et par extension s’isolent encore un peu plus.

@Nesus

“Il n’empêche qu’à augmenter la taille et la consommation sans réelle mesure, ils se tirent une balle dans le pied et par extension s’isolent encore un peu plus.”

Tu connais visiblement très bien les cibles, les tactiques et les stratégie de NVidia 😳🙄

L’arrogance de certains me laissera toujours pantois 🤢

Ils seraient sans doute incapables de gérer une supérette mais ils expliquent à des groupes très profitable ce qu’ils devraient faire 🙄

@YetOneOtherGit

Alors, un, je ne dis pas ce que Nvidia doit faire. Je constate.

De deux, éviter de tirer des conclusions sur des choses que vous ne savez pas. Parce que je suis payer pour faire la stratégie d’entreprise. Je l’ai été pour des très grosses, aujourd’hui pour des petites. Et je suis spécialisé dans la gms. Donc, si, je sais gérer une supérette, sans aucun problème et ça n’a absolument aucun rapport, mais bon, c’est votre superbe argumentation, je commence à avoir l’habitude.

@Nesus

"Alors, un, je ne dis pas ce que Nvidia doit faire. Je constate. "

Non tu juge avec des propos qui n’ont rien d’un constat factuel.

Un rien d’honnêteté intellectuelle, peut-être ? 😉

Ceci n’est en rien un constat :

"Nvidia c’est quand même de mal en pis."

@YetOneOtherGit

Alors le principe d’un texte, c’est de le lire dans son intégralité. Si extirper trois mots suffisent à comprendre le sens d’un texte à quoi ser le reste.

Donc oui, Nvidia c’est de mal en pis [...] augmentation de la consommation, de la taile[...].

Je vous laisse relire le tout et trouver vous même l’honnêteté intellectuelle.

@Nesus

"Alors le principe d’un texte, c’est de le lire dans son intégralité."

nope ça c’est le principe d’Inside macintosh.

Un texte qui doit être lu dans son intégralité pour essayer de donner du sens à chaque partie porte soit un message très complexe, soit est très mal construit.

Quand l’incipit est un jugement à l’emporte-pièce asséné avec force, difficile de passer outre, désolé 😎

Et je ne suis visiblement pas le seul ici dans ce cas.

On est tous parfois maladroits, aucune honte à l’admettre 😎

@YetOneOtherGit

Alors j’ai aucun mal, ni problème à comprendre que le message initial, n’était sûrement pas assez clair pour vous et pour quiconque. C’est même le principe de la conversation, poser des questions pour obtenir le fond du propos. Sauf chez vous, là conversation se réduit à des invectives et des tentatives d’intimidations pour vous conforter, probablement. En tout cas, j’en comprends pas l’intérêt parce que je ne vois pas en quoi ça vous fait avancer. Et pour être clair, ça ne m’intéresse pas.

J’ai donc fait 50 messages derrières, plus que développés pour répondre 20 fois la même chose, je vois qu’oomu à trouver tout seul, mais bon...

Comme encore une fois vous voulez m’attaquer personnellement nous allons jouer à un petit jeu.

« Nvidia c’est quand même de mal en pis. Ils s’isolent de plus en plus et ont des cartes de plus en plus pour une niche. La consommation du bordel... la taille, faut vraiment avoir un pc gamer pour mettre un objet pareil. »

Si on prend la première phrase ->mon sentiment sur Nvidia. Trad = Ça s’améliore pas.

Deuxième phrase = explication (c’est là où je vous ai massivement perdu, parce que vous avez clairement manquez de réflexion et vous vous êtes arrêté à un sentiment, rassurez vous, c’est la tendance du monde actuel, donc pas la peine de s’en vouloir). Trad=ils creusent le sillon de la niche.

Troisième phrase = explication de la niche. Traduction = de carte toujours plus grosses et une consommation en hausse, qui se traduisent par uniquement le pc de gamer.

Là-dessus vous êtes beaucoup à avoir répondu par, c’est une super stratégie. Ce que j’ai discuté parce que ça, ça avait de l’intérêt.

Et d’autres comme vous qui n’avez absolument pas pris la peine d’argumenter et juste dis que j’étais con et ignare parce que Nvidia se portait super bien.

Voilà ! Ce fut un plaisir. Vous constaterez aisément que le problème, c’est l’interprétation de mon message que vous en avez eu et oui comme massivement vous y avez vu un bashing sans réflexion, vous avez massivement eu exactement la même réponse. Tous (pas vraiment tous d’ailleurs) dans un égoïsme et une fainéantise patente en ne lisant même pas vos différentes réponses et surtout pas les miennes. Je sais, elles sont trop longues.

Il y a eu d’autres trucs dont je n’ai pas envie de reprendre le propos. Toutefois, j’en retiens encore deux choses. La fainéantise globale et l’incapacité de conversation d’une grande partie. Donc, je vais reprendre ma vieille manie, c’est à dire ne plus répondre, parce que je perds beaucoup de temps, pour vraiment pas grand chose.

Ps : il manque le bout sur la vram. Encore une fois, on voit bien que c’est un choix d’nvidia, mais que ça fait creuser la niche.

Un copier coller un peu rapide. Et la source était citée au passage.

@Nesus

"Vous constaterez aisément que le problème, c’est l’interprétation de mon message que vous en avez eu et oui comme massivement vous y avez vu un bashing sans réflexion, vous avez massivement eu exactement la même réponse. "

En toutes bienveillance, il n’y aucune honte à accepter la maladresse d’un propos.

Si nous sommes si nombreux à l’avoir interprété ainsi ce n’est sans doute pas que de notre faute.

C’est dommage de monter sur ses grands chevaux, il y avait certainement matière à des échanges intéressants;-)

Il y a toujours une certaine rudesse dans les échanges en ligne et une opinion qui se forge vite, tu as maladroitement présenté ton point de vue, c’est courant, rien de grave ...

@YetOneOtherGit

Encore une fois, je ne dis pas que mon propos était parfaitement clair et qu’il n’était pas à discuter. Sinon, je ne l’aurais pas précisé.

Toutefois, ça ne justifie pas la manière dont le message a été reçu. Et que vous estimez que ça fait partie de l’usage est pire encore, ça veut dire que ces manières de rustres sont juste devenus l’usage normal et donc que la conversation est forcément biaisée.

@Nesus

"Toutefois, ça ne justifie pas la manière dont le message a été reçu"

Avec cet incipit ton message est tombé dans la catégorie des nombreux “néo-troll” postant des jugements à l’emporte-pièce un rien provoquant.

Bref il y a un malentendu, c’est courant... il ne faut pas prendre ça trop à cœur 😉🖖

@Nesus

" Et que vous estimez que ça fait partie de l’usage est pire encore, ça veut dire que ces manières de rustres sont juste devenus l’usage normal et donc que la conversation est forcément biaisée."

Tout échanges est biaisé par le dispositif et les artefacts font partie de l’échange même IRL.

En ligne c’est pire, c’est évident regrettable, mais c’est ainsi.

A mon sens, il faut éviter le quant-à-soi et la susceptibilité inutile.

Prendre un peu de recul devant les reaction et en relativiser la portée.

@Nesus

"De deux, éviter de tirer des conclusions sur des choses que vous ne savez pas. Parce que je suis payer pour faire la stratégie d’entreprise. Je l’ai été pour des très grosses, aujourd’hui pour des petites."

Les arguments d’autorité sont difficilement recevables et il n’y a rien dans tes propos qui ressemble à une analyse un rien étayé<;

Pour espérer être pris au sérieux il faut montrer un rien de sérieux 😉

Donc en quoi pour toi, NVidia se tromperait de stratégie ou de tactique ?

@YetOneOtherGit

Ce ne sont pas des arguments, ce sont des faits... décidément, vous avez beaucoup de mal avec la compréhension.

@Nesus

"Ce ne sont pas des arguments, ce sont des faits... "

la mauvaise foi dans toutes sa splendeur : un jugement personnel à l’emporte-pièce n’est pas un fait mais une opinion non étayée.

« Nvidia c’est quand même de mal en pis. »

Ceci n’est pas un fait 😎

@Nesus

je ne comprends pas votre propos.

@Soner

Il y a moins de volume qu’en Avril par contre

@Nesus

"Et qui a perdu tous les plus gros marchés et perd toujours plus de partenaires."

Dans tes rêves étriqués peut-être dans la réalité c’est tout autre chose.

Les marchés sont certainement bien loin de ta vision peut-être un rien superficielle 😉

@YetOneOtherGit

Sûrement, d’ailleurs, c’est moi qui fait le marché. C’est moi qui suis allé voir Apple pour leur dire les gars, Nvidia on arrête.

Après, j’ai fait pareil avec Sony et Microsoft, parce qu’après tout ma vision et étriquée de monde vaut révélation pour les grands de l’hi-tech.

Pourquoi les plus gros vendeurs de consoles et de jeux vidéos se baseraient sur la performance et non pas à ma parole. C’est tout à fait normal.

@Nesus

Pour pouvoir maintenir les prix. Rien de plus. NVIDIA est connu dans le milieu pour ne pas vouloir baisser ses prix, partenaire ou non. Et sachant que les constructeurs de console vendent déjà a quasi pertes, il leur est très difficile d'obtenir du matériel estampillé Nvidia.

@Nesus

> C’est moi qui suis allé voir Apple pour leur dire les gars, Nvidia on arrête.

> Pourquoi les plus gros vendeurs de consoles et de jeux vidéos se baseraient sur

> la performance et non pas à ma parole.

Parce que c'est surtout un choix *financier* que de performance.

Si c'était un choix purement de performance, y'aurait du NVidia dans les consoles depuis belle lurette. Et dans des Mac Pro 2013 depuis 2013.

Bon, okay, y'a la possibilité d'avoir du NVidia dans un Mac Pro 2019. Mais c'est pas Apple qui fait ce choix, elle a juste fait le choix de ne plus vous empêcher de pouvoir le faire, nuance.

@byte_order

Non, vous ne pouvez pas réduire cela à un choix financier. Le problème du prix vient quand la concurrence est plus chère que vous, sinon, il n’y a pas de problème de prix. C’est étonnant de lire une telle chose sur un site Apple qui est quand même le spécialiste pour vendre plus cher que les autres.

Il y a un vrai problème d’intégration avec Nvidia. La hausse de la consommation, c’est pas juste un problème de carte graphique, c’est aussi un problème de carte mère, de dissipation thermique, d’alimentation... celui de la taille, c’est tout ces problèmes, plus celui du design et de la miniaturisation.

Oui Nvidia a fait un choix, c’est leur stratégie, elles leur a réussi ces dernières années, ils ont atteint clairement une limite et ça se voit.

Faut pas croire que ce que nous apprenons aujourd’hui, les industriels partenaires le découvrent aussi. Ils le savent depuis très longtemps et on fait le choix de faire sans.

@Nesus

"Oui Nvidia a fait un choix, c’est leur stratégie, elles leur a réussi ces dernières années, ils ont atteint clairement une limite et ça se voit. "

Et quel est cette limite business ?

De quel part hautement rentable et porteuse du marché NVidia se couperait ?

@Nesus

> Le problème du prix vient quand la concurrence est plus chère que vous,

Non.

Quand la concurrence est plus chère que vous *et* vend à ce prix.

Fixer un prix élevé, c'est facile.

Fixer un prix élevé et trouver quand même des clients intéressés, déjà moins.

> Il y a un vrai problème d’intégration avec Nvidia.

Ouais, parce qu'avec AMD y'en a pas non plus. Hello les cartes D500/D700 du Mac Pro 2013...

> La hausse de la consommation, c’est pas juste un problème de carte graphique,

> c’est aussi un problème de carte mère, de dissipation thermique, d’alimentation...

Les GPU NVidia ont depuis longtemps un meilleure enveloppe thermique que AMD. A perf identique, justement, si c'est pour des raisons de performances conso et thermique, le choix de AMD ne s'explique pas !

> celui de la taille,

Les puces GPU de NVidia et AMD à perf similaires sont de taille similaire.

> c’est tout ces problèmes, plus celui du design et de la miniaturisation.

Ca c'est un choix d'Apple de ne plus faire des ordinateurs qui ne soient pas tous des ordinateurs portables, mais sous différents form-factor : collés au dos d'un écran, collés (littéralement) dans un boitier de NUC.

Son choix, son impact.

> Oui Nvidia a fait un choix, c’est leur stratégie, elles leur a réussi ces dernières années,

> ils ont atteint clairement une limite et ça se voit.

Ah. On en reparle quand ils produiront le même design avec une taille de gravure plus fine...

> Faut pas croire que ce que nous apprenons aujourd’hui, les industriels partenaires le découvrent

> aussi.

Les ? Merci auquels vous pensez ? Apple, Microsoft, Sony ?

Quelques industriels.

Y'a tout plein d'autres secteurs industriels où les cartes de NVidia s'achètent limite par palette.

Pour du GPGPU par exemple, ou les salles de VR, y'a même pas photo.

Merci de ne pas réduire "l'industrie" à la seule industrie qui vend des trucs compactes.

Et d'ailleurs, les dernières PS5 et Xbox Serie X n'ont rien de "compactes" et au contraire se rapprochent de plus en plus de volume d'un PC. Alors qu'elles restent sur de l'AMD custom.

Comme quoi, la dissipation thermique et la taille c'est bien un problème existant aussi chez le concurrent d'AMD...

PS : perso j'ai une GPU AMD, hein, j'en suis content, mais au boulot je vois la différence avec une NVidia qui prend autant de place, pompe autant de watt (voir moins), chauffe moins et produit plus et plus vite.

@byte_order

Bon je ne suis pas le seul à avoir du mal à comprendre pourquoi notre camarade voit "Nvidia c’est quand même de mal en pis."

@Nesus

"Sûrement, d’ailleurs, c’est moi qui fait le marché. C’est moi qui suis allé voir Apple pour leur dire les gars, Nvidia on arrête.

Après, j’ai fait pareil avec Sony et Microsoft, parce qu’après tout ma vision et étriquée de monde vaut révélation pour les grands de l’hi-tech.

Pourquoi les plus gros vendeurs de consoles et de jeux vidéos se baseraient sur la performance et non pas à ma parole. C’est tout à fait normal."

C’est bien ça tu ne comprends strictement rien aux réalités du business 😳

https://s22.q4cdn.com/364334381/files/doc_financials/2020/q4/174b2f06-ba5b-4e0a-b288-e33c46e9a0a4.pdf

Pages