Premiers tests des Radeon Vega prévues pour l'iMac Pro

Plusieurs sites américains et français ont publié leurs premières évaluations des nouvelles cartes graphiques d'AMD, les RX Vega 56 et RX Vega 64 (Hardware.fr, AnandTech, voire TechRadar).

Leur lecture complète assouvira la soif de détails pour tous ceux que ces nouveaux GPU intéressent, pour un Hackintosh mais aussi et surtout parce qu'il vont figurer dans le futur iMac Pro attendu avant la fin de l'année.

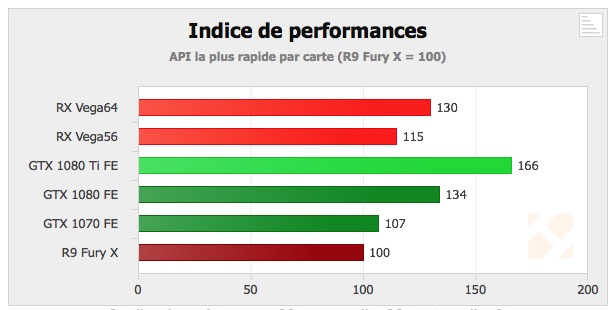

Les conclusions de chacun mettent en exergue la capacité de ces cartes à venir affronter les gros modèles GTX 1070/1080 de Nvidia bien installés dans le paysage. Cependant Nvidia a toujours du répondant et ses solutions restent très pertinentes.

AnandTech décrit des Vega 64 au coude-à-coude avec les GeForce GTX 1080 pour les jeux, dans une définition de 3820x2160. Cependant la GeForce devance parfois nettement sa concurrente.

Surtout, la différence de consommation électrique n'est pas du tout à l'avantage de la nouvelle carte d'AMD. Avec 295 Watts, elle dépasse de 110 à 150 Watts les modèles Nvidia.

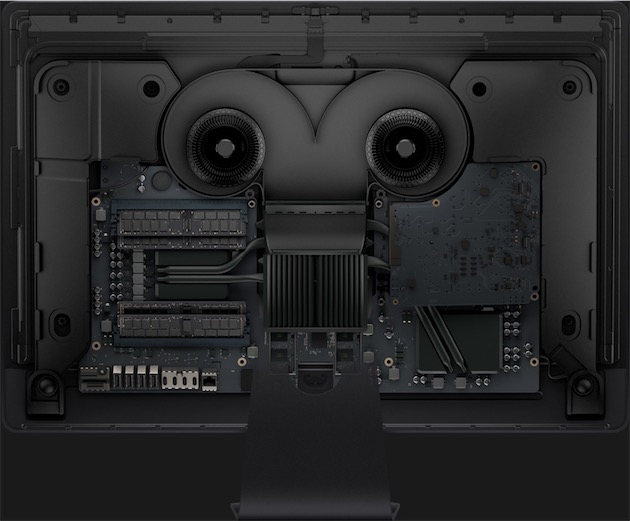

Apple va avoir fort à faire pour tempérer ces excès, la ventilation de l'iMac a été revue et cela peut passer aussi par une décélération de la puce graphique utilisée. La fiche technique de cet iMac s'en tient pour l'heure à des informations basiques et parle sommairement de "Radeon Pro Vega 56 et Vega 64".

La Vega 56 montre une consommation plus élevée aussi que sa concurrente la Nvidia GTX 1070 (de 45 à 75 W plus importante) et elle est en moyenne 8 % plus rapide que cette dernière. Comparée à la Vega64, elle offre environ 90 % de ses performances.

Cool

Et par rapport à un Mac Pro actuel par exemple , on a une idée de ce que ça donne ?

@moon21

Le jour et la nuit.

La nuit, c'est le Mac Pro 2013 ?

La nuit et le crepuscule: Avec 295 Watts, elle dépasse de 110 à 150 Watts les modèles Nvidia.

Ou alors la nuit et un BBQ :)

295 Watts dans un iMac... en fait Dyson aurait pu le faire: iMac Pro, le BBQ par Dyson...

J'espere qu'on pourra changer facilement ces cartes (par exemple quand elles lâchent en plein rush...).

Sinon bonjour la facture et l'immobilisation de la machine !

@kitetrip

Ça lache plus comme ça les cartes... Quand je vois qu'au bout de 4 ans de chauffe excessive mon MBP 13" fonctionne parfaitement je me dis qu'un iMac avec une ventilation comme ça ne posera pas de problèmes.

Ton MBP 13" n'a pas de carte dédiée, c'est peut-être pour ça qu'elle lâche pas. ^_^

@ LolYangccool

«on MBP 13" n'a pas de carte dédiée, c'est peut-être pour ça qu'elle lâche pas. ^_^»

ho,ho, bien vu le commentaire, arf!

Il est toujours bon de rappeler que les mac pro 2013 ont eu des problèmes de dissipation de chaleur sur certaines apps et ce n'était pas du à une mauvaise batch, tous les modèles ont ce problème.

Une boite d'étalonnage sur Paris a perdu plus de 60 000 € car tous ses mac pro, tous sans exception, ont grillés lors de rendus sur Da Vinci Resolve.

Cet iMac va connaître le même sort, les gens qui ont besoin d'une machine à 18 cores, 128 GB de ram et des grosses cartes graphiques iront les prendre sous format tour.

Les benchs des Vega sont très inquiétants pour l'iMac Pro car ils montrent que la dissipation thermique va être beaucoup plus importante que prévue et le format de l'iMac Pro malgré ses "deux nouveaux" ventilos n'y changera rien, pour garder le tout à bonne température, Apple modulera les fréquences lors de l'utilisation ce qui résultera par une baisse des performances et sur les apps qui ne sont pas optimisées (donc pas FCP X) et plus utilisées par les pros (Adobe, Da Vinci ) l'iMac grillera purement et simplement exactement comme le Mac Pro 2013.

Elles ne lâcheront pas, et si jamais c'est le cas, c'est remplacement de la machine. T'inquiètes pas chez Apple le SVA est présent.

Elles grilleront comme le Mac Pro 2013 (voir commentaire plus haut)

Ensuite en parlant du SAV, chez Dell et chez HP c'est le technicien qui vient sur le site en 2h, alors que chez Apple, le client pro doit se déplacer, je rappelle encore une fois l'histoire d'une société d'étalonnage parisienne qui a perdu 60 000 € sur des mac pros qui ont grillés et qui n'étaient pas issus des bench dites défectueuses, car en vrai elles le sont toutes en raison du design même de la machine.

De plus , cette société d'étalonnage a vu ses mac de remplacement eux aussi griller, ils sont passé sur des ordis format tour sous linux pour Da Vinci, résultat, plus de 60 000 € de perdu sans compter le prix des PC qui ont remplacer les mac pro, mac pro qui d'ailleurs, contrairement aux iPhone et iBidule, ne se revendent pas bien en occasion, aujourd'hui en 2017, un Mac Pro 2013 8 coeur, 64 GB de ram et dual D700 ne vaut plus rien, Apple a donc avec cette machine brisé beaucoup de ses qualité : la fiabilité et la côte de revente en occasion et l'iMac Pro connaitra le même sort.

Je peux comprendre que pour des petites boites de prod, des photographe indés et des petits studios de mixage qui n'ont pas envie de passer sur Windows ou Linux, ils acceptent de rester enfermés chez Apple, l'entrée de gamme de l'iMac Pro leur suffira largement mais pour ceux qui font des travaux lourds, montage de fiction, mixage de fiction, étalonnage, effets spéciaux, jamais ces personnes ne seraient assez folles pour prendre un iMac pro ca serait du suicide professionnel pure et simple.

Ca me rappelle une autre histoire, d'un autre genre mais qui a contribué à détruire la relation entre Apple et les pros, une autre boite de post-prod qui avait massivement investi dans les solutions de serveurs dédiés à FCP 7 et qui 3 mois après apprend qu'Apple les retire de ses produits, eux aussi ils l'ont eu très mauvaise.

@kitetrip

T'es pas au courant: on pourra meme pas acceder a la RAM, la machine sera une boite a sardine scellée avec une turbine pour faire souflerie qui occupera le peu d'espace restant.

Et le TDP de 295 Watt du GPU c'est EN PLUS du TDP du Xeon...

Deja si l'ecran ne fond pas au bout de 15 min ce sera un exploit.

Exact, et les exploits ne sont pas l'apanage d'Apple, pourquoi ni Dell ni Hp ne peuvent proposer une machine identique à l'iMac Pro ? Parce qu'il est tout simplement impossible de dissiper la chaleur de ses composants dans un si petit espace. Mais apparement ici on est que 2 à le savoir..

@JohnDevil

"Exact, et les exploits ne sont pas l'apanage d'Apple, pourquoi ni Dell ni Hp ne peuvent proposer une machine identique à l'iMac Pro ? Parce qu'il est tout simplement impossible de dissiper la chaleur de ses composants dans un si petit espace. Mais apparement ici on est que 2 à le savoir.."

On en reparlera quand l'iMac pro sera là…S'il arrivera à bien dissiper la chaleur tu chercheras à l'attaquer sur autre chose ou tu avoueras t'être trompé lourdement?

C1rc3@Orc l'a déjà dit plusieurs fois et il est bon de le rappeler, on sait déjà tout des composants de cet iMac, le TDP des radeon va monter jusqu'à 353 watts, l'iMac Pro ne peut gérer que jusqu'à 500 watts selon les dires même d'Apple, donc oui, il va griller, exactement comme le Mac Pro a griller, et pour empêcher cela, Apple jouera sur les fréquences du proc et du GPU qui seront donc à la ramasse et il grillera sur les applications qui passeront outre cette sécurité comme Da Vinci ou Première, comme pour le Mac Pro 2013, n'oublions pas l'exemple que je cite à chaque fois de la boite d'étalonnage qui a perdu plus de 60 000 € de Mac Pro (ou alors ce sont des "amateurs" peut être ?....Eux ils l'ont mauvaise, très mauvaise et n'iront plus jamais chez Apple...)

Il n'y a pas vraiement besoin d'attendre qu'il arrive. Les personnes qui ont besoin d'ordinateur à 7 000 - 20 000 € pour du montage, mais surtout des VFX et de l'étalonnage iront sur PC (windows ou linux vu que Da Vinci est sur Linux) afin d'avoir des machines sous format tour, mieux ventilées et donc plus performantes. Il faut à un moment arrêter d'avoir des oeillères sous prétexte que c'est Apple, ils ont beau avoir de bon ingénieurs, personne n'est capable de gérer la chaleur dégagée par des éléments aussi puissants dans un environnement aussi petit, parce que c'est IMPOSSIBLE. Donc non, je ne risque pas de revenir sur mes propos, puisque l'avenir me donnera raison.

@C1rc3@0rc

"T'es pas au courant: on pourra meme pas acceder a la RAM, la machine sera une boite a sardine scellée avec une turbine pour faire souflerie qui occupera le peu d'espace restant."

Mais quand on regarde la ram proposée de base et encore plus en option la "boite à sardine" embarque de quoi être tranquille coté ram les 10 prochaines années … Tu ne voudrais pas un tera de ram pour faire beau quand même?

J'ai aussi vu un compte rendu faisant état de performances légèrement supérieurs avec les applications qui font du gpgpu et la productivité (un peu comme Ryzen et Threaderipper, en somme). Bref, c'est plutôt une bonne chose en ces termes : AMD a enfin des cartes qui font jeux égal avec nVidia.

Tout le monde dit : "ouaip mais y'a Volta qui doit débarquer".

Peut être mais si AMD est malin, il a déjà prévu que son itération suivante sera un compétiteur a Volta.

Il aurait d'ailleurs tout intérêt à ce que ce soit le cas.

Bref, l'offre est plus large, les performances correctes chez tout le monde.

@Hasgarn

Ben si tu lis les evaluations des diverses publications specialisées, le sentiment general est une enorme deception pour les Vega.

Le tout haut de gamme d'AMD arrive dans le meilleur des cas au niveau de la NVidia GTX 1080, mais reste loins derriere la GTX 1080Ti, pour une consommation superieure d'au moins 50%.

«Peut être mais si AMD est malin, il a déjà prévu que son itération suivante sera un compétiteur a Volta.»

AMD est tres en retard par rapport a Nvidia et les Vega ont en ligne de mire l'architecture Maxwell de Nvidia, alors que Nvidia est en train le passer de Pascal (successeur de Maxwell) a Volta qui promet encore un saut de performance et une grosse amelioration de l'efficacité energetique.

La ou AMD met la pression, c'est sur le GPGPU avec un FP16 et un FP32 qui ne sont pas artificiellement bridés comme le fait Nvidia sur ces modeles grand public (pour pouvoir vendre plus cher des cartes "pro" certifiée). Mais il suffit que Nvidia change de politique commerciale et leve le bridage des GTX xxxx qui les limite artificiellement et les Vega perde d'un coup de seul petit levier dont elles disposent.

Bref comme je le disais depuis longtemps, on pouvait s'attendre a une déception avec les Vega, c'est confirmé et lourdement.

Le choix d'Apple d'exclure Nvidia des ses Mac confirme une erreur strategique majeure d'Apple et surtout exclu d'office les Mac de beaucoup de secteurs :(

Maintenant, soit Apple continu dans cette impasse et le Mac ne va plus etre qu'une machine tres grand GP (si le tarif et les tares infligées aux portables ne les condamnent pas a moyen terme), soit Apple remet des Nvidia dans ses Mac.

Oui mais les Radeon vega sont moins chère aussi non?

Pour l'instant non elles sont au meme prix grosso modo, mais c'est quasiment sur qu'il y aura une baisse dans quelques semaines.

Si même sur le plan de la consommation Nvidia est meilleur quel est l'intérêt pour Apple de mettre ces cartes AMD ...?!

Certaines applicatons tirent mieux parti des Radeon, et la consommation est un problème secondaire.

@Montage

Mais pas le refroidissement, en particulier sur un tout en un ?

Y a vraiment un truc que je n'arrive pas à comprendre avec ce modèle, je veux bien qu'ils aient refait l'archi interne, mais au point de caser une carte qui consomme encore plus qu'une 1080 ? Et le système de refroidissement fait le taf, alors que l'iMac que j'ai à la maison avec son pauvre chip mobile souffle comme pas possible dès que je lance un jeu ?

Perso je vois aucun intérêt à y caser une Radeon à la place d'une GeForce, quand la première consomme beaucoup plus.

Ça sent le vieux deal entre Apple et AMD à plein nez, pour qu'ils puissent marger un peu plus pendant que les clients se retrouvent avec du matos pas optimal.

Sur un ordi qui commence à 5000$ hors taxe, ça commence à faire mauvais genre quand même.

@Rez2a

Je ne pense pas que ça pose problème, le système de ventilation associé à la grande surface de l'iMac peut permettre une ventilation très efficace.

Il n'y a qu'à voir le Mac Pro tube qui est un exemple en terme de dissipation thermique (malgré ce que pensaient les gens)

@fousfous

Le Mac Pro c'est encore autre chose.

Pour l'iMac 27", on a déjà de nombreux modèles, depuis des années, et on sait qu'ils soufflent en continu alors qu'ils ont des chips graphiques qui consomment 10 fois moins que ce qui est annoncé là.

Alors on sait qu'ils ont repensé la ventilation sur l'iMac Pro, c'est vrai. Mais il va falloir un sacré tour de magie pour que ça puisse encaisser tout ça, et surtout c'est complètement stupide de ne pas utiliser un composant déjà éprouvé, qui est plus performant tout en consommant beaucoup moins.

Au passage, ça serait sympa aussi qu'ils mettent à jour les iMac classiques avec cette nouvelle architecture, pour que les clients qui n'ont pas besoin de processeurs à 64 coeurs aient aussi le choix d'acheter une machine normalement dimensionnée au niveau des perfs graphiques.

Mais bon j'ai vraiment de gros doutes sur ce que va pouvoir endurer cet iMac Pro.

J'ai du mal à croire qu'il va pouvoir faire fonctionner des CG qui consomment autant, sans brider leurs performances, et sur la durée. C'est pas une rev A que je me risquerais à acheter...

@Rez2a

La ventilation du dernier MacBook Pro est excellente, malgré la taille du boîtier.

Apple a fait beaucoup de progrès de ce côté là et commence à avoir une certaine expérience.

À mon avis faut attendre avant de crier au loup ;)

@Hideyasu

Apple a une maitrise du refroidissement qui est une reference dans le domaine depuis tres longtemps, pourtant malgré les promesses et l'urgence jamais l'equipe des ingenieurs d'Apple n'a reussi a installer un refoidissement suffisant dans ses portables pour y faire tourner un G5 conçu pour les tours!

C'est la raison qui a fait qu'Apple a abandonné le PowerPC et a du passer au Core d'Intel. Et pourtant les clients ont attendu longtemps la machine, mais c'etait impossible.

L'histoire de l'iMac Pro ressemble beaucoup a celle du portable a G5.

Et il ne faut pas oublier qu'un cause principale des problemes de fiabilité du Mac Pro 2013 c'est inefficacité du refroidissement.

Dw plus dans un Macbook Pro, on a souvent pas de GPU et toujours un processeur qui est ultra optimisé pour eviter de trop chauffer, quitte a degrader les performances de maniere drastique. Le TDP d'un MBPro c'est 40Watt au pire.

La on parle uniquement d'un GPU qui atteint les 300Watts, auquel il faut rajouter 140 watt pour le CPU!!!

Honnêtement y a pas grand monde aujourd'hui qui croit qu'Apple va reussir a realiser un iMac Pro.

Reste a esperer qu'Apple a dans ses cartons une tour ou une minitour et que ça va sortir rapidement, parce que sinon le mac va etre definitivement exclu des domaines de la VR, de la video, du GPGPU,...

@Rez2a

Les utilisateurs cherchant des perfs ont les moyens. Apple continue à s'obstiner avec AMD. Je présageais le pire quand j'ai compris qu'AMD proposeait une version qu'en Water colling!

La GTX1080Ti c'est 250W pour 11Tera Flops de perfs. Qui dit mieux? C'est ce que je vais glisser dans mon Mac Pro 5.1, qui lui a été conçu pour dissiper.

Je rejoins ta crainte: l'iMac Pro sera ou bien comme le Mac Pro 2013 avec une fiabilité douteuse ou alors ils vont brider les perfs d'une manière improbables: cela va calculer beaucoup mais pas longtemps...

«Je rejoins ta crainte: l'iMac Pro sera ou bien comme le Mac Pro 2013 avec une fiabilité douteuse ou alors ils vont brider les perfs d'une manière improbables: cela va calculer beaucoup mais pas longtemps...»

Ou alors Apple va accumuler les retards et finalement renoncer a sortir une machine impossible... Le spectre de l'histoire du portable G5 plane sur cette machine.

C'est vrai, mais le problème, c'est que les Nvidia sont mal exploitées avec Final cut pro.

Ma ATI 7970 gère plus rapidement les rendus avec le GPGPU et open CL que la Nvidia 1080....

Le Mac Pro tube est l'exemple même d'une mauvaise dissipation thermique (voir mes commentaires précédents) des boites entières ont vu leur mac pro originaux et de remplacement griller !!!

C'est pas uniquement une entente AMD/Apple, c'est aussi que Apple fait payer cher à Nvidia de vouloir jouer sur leur terrain. Nvidia est en train de devenir le meilleur sur le plan de l'informatique embarquée dans les voitures autonomes de demain, et ça, la Pomme ne le supporte pas du tout...

@iOx2

La plupart des applications sont optimisés pour AMD et Apple ne veut pas forcément encourager les pratiques déloyales de nvidia avec cuda.

Et puis si les ingénieurs s'entendent mieux entre eux c'est un point positif en plus.

«La plupart des applications sont optimisés pour AMD »

hein? Quelles applications, dans quels domaines?

De ce que je connais, a part les applications Apple, tout ce qui fait appel a du GPU mais egalement du GPGPU sont majoritairement optimisés, quand c'est pas uniquement conçu, pour Nvidia et CUDA.

Ça va chauffer. IMac special soufflerie.

L'attente était énorme sur ces cartes et la déception n'en ai que plus grande. Un an après Pascal, AMD se met à peine au niveau d'une 1080 avec 100W de plus, et reste bien loin de la 1080 Ti (qui consomme toujours moins que la Vega 64 !). Malheureusement pour nous, consommateurs, la partie GPU de AMD va suivre le désastre de ses CPU avant Ryzen. En espérant un Ryzen à la sauce GPU, mais pour quand ?

Ce n'est pas étonnant, AMD nous ressort toujours la même archi modifiée par petite touche au fil des ans, et on connaît ses limites. Mais ils n'ont pas le budget d'un Nvidia pour refondre leur architecture.

Même en Dx12 elle ne brille pas particulièrement, à voir à l'avenir quand les jeux utiliserons massivement les nouvelles APIs, mais alors Volta sera là.

Bref, POURQUOI Apple utilise ces cartes dans un espace aussi confiné où la moindre calorie économisée est importante. Soit les cartes vont se bridées avec des baisses de fréquences, soit ça va être un four. Impossible de sortir la CB en sachant qu'Apple gratte quelques dollars pour des composants au rabais.

@Lawliet

En quoi c'est un composant au rabais? En tant qu'utilisateur ce qui compte le plus c'est les performances, que ça consomme plus n'est pas dramatique tant que le système de ventilation est adapté (et il l'est).

Et comparer une vega 64 avec une 1080 TI il faut le faire vu la différence de prix...

Avec AMD Apple a aussi plus de marge pour avoir une carte adapte à ses besoins contrairement à nvidia.

Donc non ce n'est pas qu'une question d'économiser quelques sous.

@fousfous

Donc in devrait aussi éliminer les iPhones des comparatifs vus la différence de prix???

@0MiguelAnge0

Bah tu imagines bien que c'est stupide de comparer un iPhone a un machin Android bas de gamme et du coup de conclure qu'en effet l'iPhone est mieux...

Il ne faut pas oublier de ramener au prix, surtout quand c'est aussi "simple" a comparer que des performances brutes.

Au rabais par le rapport performance par watt. Justement, le prix n'est pas très différent. Le placement tarifaire est désastreux, la Vega 64 va faire un bide, c'est certain. La 56, tout dépendra de son placement par rapport à la 1070, mais vu les prix annoncés, c'est mal parti aussi ...

Et clairement, je vois bien AMD faire un prix à Apple pour refourguer leurs chips...

Et on ne sait rien de la ventilation de l'iMac Pro. Ca sera peut-être comme les iMacs qui ventilent déjà assez fort, ou peut-être pire

@Lawliet

Les gens regardent tant que ça la performance au watt? Si je doit m'acheter une carte graphique je regarderai plutôt le rapport puissance/prix.

Et n'oublie pas qu'Apple adapte légèrement la puce à ses usage, notamment pour les e/s comme le TB3.

Au delà du rapport performance/watt, c'est le simple fait de savoir que je pourrai en avoir plus si Apple ne s'obstinait pas dans ses choix. Mais je ne fais pas parti de la grande majorité des gens qui ne se soucie pas de ça.

Il y a sûrement d'autres paramètres à prendre en compte, je te le concède. On vera leurs perfs en OpenCL vs Pascal aussi. Même si encore une fois, avoir la possibilité d'exploiter Cuda serait un gros plus.

@Lawliet

Enfin personnellement je suis pour l'idée de tuer cuda dont la seule et unique raison d'exister est de tuer la concurrence

Bon là je suis assez d'accord.

C'est vrai tuer le truc une techno plus aboutie qu'open CL est une bonne idée...

Mais alors autant tuer metal qui est une saloperie propriétaire alors que vulcain est multiplateforme...

Allez essayes de trouver une solution pour ne pas passer pour un ***

@fousfous

Apple, Championne des solutions propriétaires!!!

Si l'industrie se jette sur Cuda, c'est peut-être qu'il n'y a pas d'autre alternative standardisée qui fasse aussi bien?!

Euh Nvidia supporte aussi pas mal de standards..

Ben mon petit père, il faudra rajouter la facture électrique pour avoir un réel rapport performance prix. Et paf, nvidia fait bien mieux et pas besoin de s'arracher les cheveux pour refroidir le bouzin!

Il faut remarquer que si la conso et le dagagement tehrmique n'ont que peu d'impact dans l'utilisation sur une tour de type station de travail dans le cadre d'une utilisation en individuelle ou une petite equipe, la question devient un point de bascule des qu'il s'agit d'utiliser plusieurs GPU dans une machine, de faire appel a plusieurs machines pour mouliner les traitement d'autant dans les domaines de l'image ou du GPGPU.

Le cout electrique (consommation de la carte plus conso du systeme de refroidissement, plus les boulles quies ou le QC35) entre un PC avec un AMD et un PC avec une Nvidia, n'est pas un probleme. Par contre, la difference croit tres vite si on multiplie les PC et les GPU par PC. Et la Nvidia sort tres, tres vite vainqueur.

Aujourd'hui le seul avantage d'AMD c'est que ces GPU n'ont pas les limitations artificielles pondues par le marketing de Nvidia. Dans le domaine du GPGPU, les Vega seront utilisables alors qu'il faudra passer sur des Quaddro chez Nvidia... du moins si Nvidia ne revoit pas son marketing d'ici la.

@fousfous

"En quoi c'est un composant au rabais? En tant qu'utilisateur ce qui compte le plus c'est les performances, que ça consomme plus n'est pas dramatique tant que le système de ventilation est adapté (et il l'est)."

La consommation est primordiale. L'énergie est notre avenir, du moins le miens ;)

Je pense qu'Apple ne nous a pas tout montrer sur les photos des iMac Pro.

Ce que l'on voit c'est le boîtier de l'ordinateur avec tout dedans sauf la carte graphique qui sera dans un boîtier séparer.

Je ne vois pas comment ils pourraient tout mettre dans un boîtier d'iMac sans que cela prenne feu.

Pages