Pourquoi la transition vers des Mac ARM est inévitable

Plus de dix ans sans transition. Quand on connait l’histoire du Mac, on sait qu’Apple fait de temps en temps des choix radicaux pour ses ordinateurs : des Mac 68k au PowerPC, du PowerPC aux puces Intel…

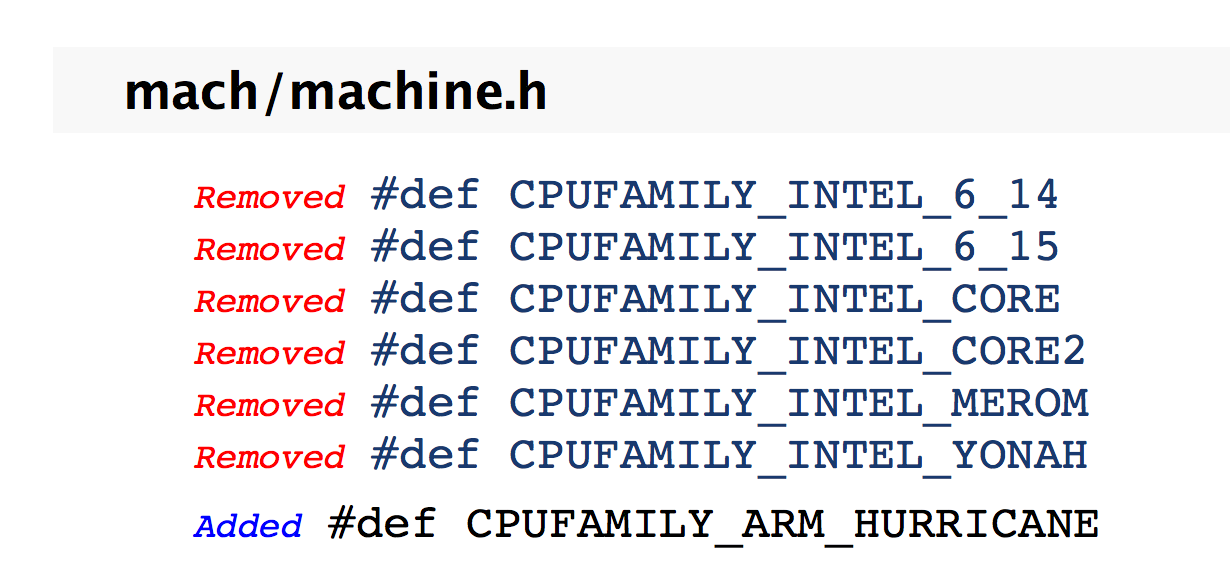

Sommes-nous à l’aube d’une nouvelle transition ? La documentation d’Apple mise à disposition des développeurs peut le laisser penser. La firme de Cupertino a pour habitude de lister toutes les différences en ce qui concerne ses API d’une version à l’autre (un procédé courant). Dans celle relative au Kernel de Sierra, Apple a ainsi retiré plusieurs références à d’anciens processeurs Intel qui ne sont plus gérés par macOS comme les puces Merom. Jusque-là, rien de bien surprenant. La vraie surprise est de constater que tout en dessous, on voit qu’elle a ajouté la prise en charge de la famille de processeurs ARM Hurricane. Ce n’est pas une puce connue, sans doute un nom de code. Hurricane signifie en anglais, rappelons-le, ouragan. Voilà qui a le mérite d’être clair.

En tout cas, comme le note iDownloadblog, ce nom de code colle bien avec les noms de code des anciennes puces d'Apple. Le petit nom de l'A7 était Cyclone, A8 Typhoon et A9 Tornade. Hurricane serait le nom de code de l'A10, d'après Hardware.fr, qui s'appuie sur les découvertes de Chipworks qui a l'habitude d'autopsier les composants des nouvelles puces d'Apple.

Qu’Apple étudie la possibilité de produire des Mac ARM, cela n’a rien d’étonnant. Cela fait maintenant quelques années qu’elle explore cette possibilité comme elle l’a fait en d’autres temps pour d’autres architectures. Mais va-t-elle passer à l’acte ?

Le très réputé Ming-Chi Kuo tablait sur de tels ordinateurs pour 2016 ou 2017 (lire : Mac ARM : dans les deux ans avec un processeur A10X ?). A l’époque, il estimait que l’A10X pourrait être le futur moteur d'un Mac ARM. Avec le recul, ses propos sont très intéressants. Les tests effectués il y a quelques jours avec Geekbench montraient que le processeur A10 Fusion de l’iPhone 7 n’avait plus grand-chose à envier en termes de puissance brute à un MacBook Air. Alors certes, Geekbench ne reflète pas forcément la réalité, mais la dynamique et la montée en puissance penchent clairement pour le camp ARM.

Pour Apple, la difficulté est avant tout matérielle contrairement aux autres transitions. D’un point de vue logiciel, elle pourrait être plus indolore pour les développeurs. La compatibilité ne devrait pas être un problème. Apple maitrise les outils de développement (du langage de programmation aux API en passant par les compilateurs), elle contrôle la distribution avec le Mac App Store et a plus qu’un pied dans le monde ARM depuis maintenant une décennie ou presque.

Pourquoi le modèle d'Intel est dépassé

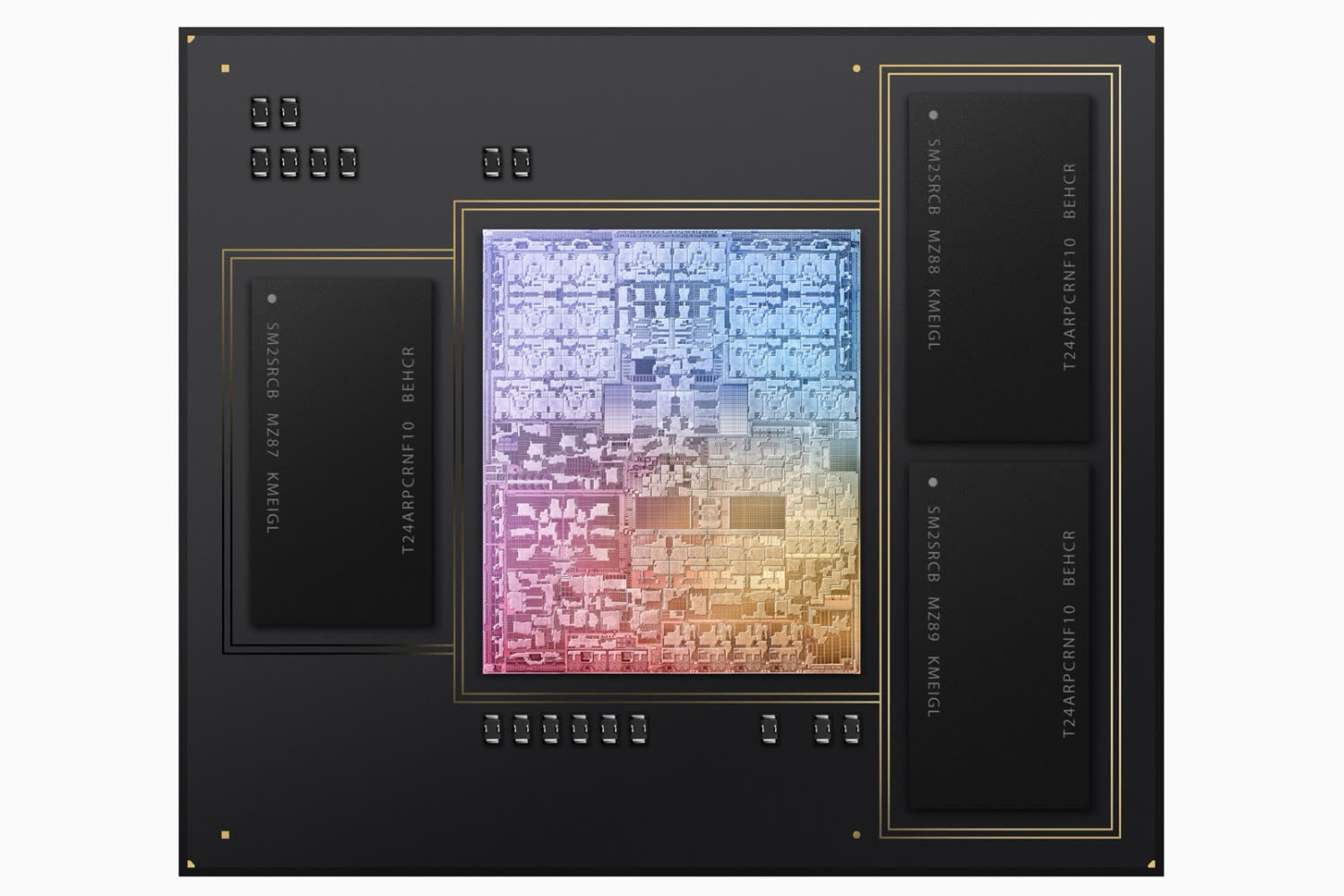

La difficulté pour Apple est d’être en mesure d’avoir dans ses cartons un processeur vraiment compétitif par rapport à ce que propose la concurrence. Sachant que la complémentarité logicielle / matérielle joue à plein et au vu des scores affichés par le processeur A10, cela n’a rien d’insurmontable. Dans un tel scénario, la grande force d’Apple serait de pouvoir concevoir un processeur vraiment taillé pour faire tourner au mieux la partie logicielle.

La fin de la loi de Moore offre des perspectives intéressantes comme l’explique le chercheur Mark Pesce sur The Register. Pour lui, l’actualité des processeurs ces dernières semaines se résume à trois points :

- La prochaine génération de processeur Intel ne va pas beaucoup plus vite que la précédente (lire : Intel lance Kaby Lake, la 7e génération de processeurs Core) ;

- Intel a pris beaucoup de retard sur la gravure en 10 nm (lire : Intel retoque son Tick-Tock) ;

- La puce A10, que l’on retrouve dans l’iPhone 7, est un processeur très rapide.

D’après Mark Pecse, la formule qui a fait le succès d’Intel ne fonctionne plus. La seule chose dont le monde a besoin, c’est : "toujours plus de transistors, et des transistors toujours plus petits". Cette formule a fait le succès de la plateforme Wintel, mais elle n’est plus pertinente à l’heure actuelle.

Ces cinq dernières années, Apple n’a eu de cesse d’avoir toujours plus de contrôle sur le matériel dans ses terminaux, et a amélioré de manière spectaculaire le niveau de performance de ses processeurs : un facteur de 12 sur ces cinq dernières années. Mais contrairement à Intel, cette progression ne vient pas du fait (ou pas seulement) de l'utilisation d'un nombre toujours plus élevé de transistors, lesquels sont toujours plus petits. Si ces puces progressent en efficacité, c’est parce qu’Apple utilise uniquement les transistors dont elle a besoin dans ses tablettes. Et c’est là où tout commence pour Apple.

Nous sommes entrés dans une ère où logiciel et matériel se confondent de plus en plus. La puce A10 est optimisée à fond d’un point de vue matériel pour travailler efficacement avec le noyau d’iOS sur la gestion d’énergie.

Pour le co-inventeur du VRML qui écrit de temps à autre pour The Register, le matériel va dans les prochaines années happer le logiciel. La frontière entre les deux sera de plus en plus ténue. Et cette maitrise du logiciel et du matériel, cette fusion même, est sans doute l’un des gros points forts d’Apple actuellement.

Pour le dire autrement et plus simplement, on entre dans l’ère du sur-mesure en matière de système-sur-puce, alors que jusqu’à présent, on faisait du prêt-à-porter.

Si Apple est sans doute en pointe dans le domaine, c’est loin d’être un cas isolé. De plus en plus d’acteurs s’y sont mis, notamment Microsoft et Google (lire : Comme Apple, Google voudrait son propre processeur).

Cette évolution explique sans doute le retournement d’Intel cet été. Le géant des semi-conducteurs a annoncé son intention de fabriquer à nouveau des processeurs ARM pour les produits mobiles (lire : Intel va fabriquer des processeurs ARM pour les constructeurs de produits mobiles). Mais n’est-ce pas déjà trop tard ? Le risque pour Intel n’est pas de disparaitre, mais de devenir un vulgaire sous-traitant se pliant au cahier des charges de ses partenaires.

Enfin, si en 2017 on voit vraiment des Mac ARM apparaitre sur le marché, on comprendra rétrospectivement pourquoi 2016 a été si calme sur ce front chez Cupertino.

@reborn

Tout ce que la planète compte de spécialistes en IHM même débutant acte cela depuis bien longtemps : Le Wimp ne s'accommode pas d'une interface tactile même mutitouche.

Même les équipes de MS n'était pas en accord avec les volontés d'hybridation qui ont conduit à W8 puis aux Surface Janusinenne.

Ce sont de pures approches marketing opportunistes et stratégiquement intelligente : aller là où Apple n'ira pas ;-)

On parle d'Apple là !

Si Apple met de l'ARM dans un mac, elle se privera pas de supprimer tout ce que le x86 fait mieux. Même l'USB et le Thunderbolt si il faut.

Apple c'est comme ça, elle va trouver l'équation qui va vous frustrer d'acheter (quand même) son dernier produit. Et ca fera table rase du passé.

Imaginez la promesse d'un macbook pro 15" retina deux fois plus léger avec autant d'autonomie et un clavier tactile super pratique. Imaginez que toute la presse qui l'a touché affirme que ça change la donne, qu'on s'y habitue très vite, que c'est révolutionnaire... On ne vois plus de reflets du tout grace à un capteur qui les effaces en temps réel. (etc, fantasmez un peu)

Et imaginez que cette machine n'a que 3 ports USB-C et un lightning qu'elle tourne avec un A10x et que la logitèque est certes large, mais pas autant que les mac x86.

Voilà, vous avez trouvé le point de transition acceptable.

Maintenant d'un point de vue conception, imaginez la complexité de gérer de la RAM, des ports divers et varié, des définitions d'écran multiples, ... et ne gérer que l'USB-C (et aller, Bluetooth et Wifi, parce que je suis sympa et parce que c'est sur l'iPad...)

Exit tout le code de merde qui s'est empilé pendant des années pour gérer des machines qui sont en fait des hybrides complexes mal assumés.

Un peux comme les PC en 1998 qui avaient un port série, un port parallèle, un port pour le souris et un autre pour le clavier ...

Là où déjà le mac avait l'ADB et qu'Apple a remplacé "ça" par l'USB.

Ceci n'est qu'un exemple focalisé sur la connectique.

On peut voir aussi l'abandon de librairies 3D (Metal uniquement, allez, à la limite, OpenGL), de système de fichiers, de protocoles réseaux, ... Apple fera sa tambouille et vous adorerez être frustrés.

@Un Type Vrai

Excuses moi mais je trouve ton propos complètement idiot et même en essayant d'être diplomate je ne vois pas comment adoucir ce jugement.

Sans même parler des considération technique en préambule qui sont plus que tiré par les cheveux, qu'est-ce qui dans le passé d'Apple sur les Mac peut raisonnablement te laisser penser qu'ils considéré que la connectivité est une hérésie à éradiquer ?

C'est du délire pure et simple ne reposant sur rien, plein d'élucubrations techniquement inepte pour se ramener en fait à un procès d'intentions.

Assez alunissant en fait, je ne vois qu'un niveau prés élevé de frustrations et d'acrimonie vis-à-vis d'Apple pour produire de tel délires.

L'idiot est celui qui ne comprend pas le fond de mon propos.

Prend 2 pas de recul et relis mon post.

Surtout :

"Ceci n'est qu'un exemple focalisé sur la connectique."

Merci.

@Un Type Vrai

""Ceci n'est qu'un exemple focalisé sur la connectique."

Justement quand on voit les inepties que tu professées sur les enjeux de connectique il est difficile d'en accepter une exemplarité pour le restant de ton propos :-)

@Un Type Vrai

"Si Apple met de l'ARM dans un mac, elle se privera pas de supprimer tout ce que le x86 fait mieux. Même l'USB et le Thunderbolt si il faut."

Il n'y a pas d'obstacle technique majeur à un support de l'USB et du TB sur une architecture ARM.

Et au passage Apple à été un fer de lance de l'adoptions de ces interface et de la proposition à ses utilisateurs de leurs usage (Même si pour l'USB-C ils prennent un peu de temps)

Pour le reste de tes réponse, vu que tu penses que JE suis frustré, que JE veux revenir sur les ports multiples etc, enlève tes oeillères.

Mon propos est plutôt :

Le Mac sur ARM sera différent et Apple n'hésitera pas à couper ce qui l'empèchera de proposer ce qu'elle considère comme l'avenir.

Point barre.

Tes jugement à l'emporte pièce sur fond de mauvaise foie et d'attaque personnelle sont totalement hors sujet et malvenus.

@Un Type Vrai

"Pour le reste de tes réponse, vu que tu penses que JE suis frustré, que JE veux revenir sur les ports multiples etc, enlève tes oeillères."

Je ne le pense pas, j'émets des hypothèses pour essayer de comprendre comment on peut en arriver à proférer de tel propos qui tiennes franchement du grand n"importe quoi.

Je ne suis que très dubitatif sur comment tu peux en arriver là, nulle certitude ;-)

@Un Type Vrai

"Apple c'est comme ça, elle va trouver l'équation qui va vous frustrer d'acheter (quand même) son dernier produit. Et ca fera table rase du passé.

C'est bien ta frustration et ton acrimonie qui ont pris le contrôle de ton esprit, ok :-)

@@Un Type Vrai

"Et imaginez que cette machine n'a que 3 ports USB-C et un lightning qu'elle tourne avec un A10x et que la logitèque est certes large, mais pas autant que les mac x86.

3 ports USB-C (supportant espérons le le TB3) c'est superbe où est le pb.

On pourrait sans doute espérer 1 ou 2 ports de plus mais à part ça ...

Les caractéristique que tu mets en avant sont fort alléchante et trouverait certainement un beau marché.

Je le répète où est le pb ?

@@Un Type Vrai

"Maintenant d'un point de vue conception, imaginez la complexité de gérer de la RAM, des ports divers et varié, des définitions d'écran multiples, ... "

Effectivement Apple montre depuis des décennies qu'ils ne produisent que des produits simplisme ...

Il n'y a rien de particulièrement complexe et inabordable pour Apple au regard de se qu'il affronte en terme de défis d'ingénierie depuis des décennies dans ce que tu énonces.

Où est le pb ?

@@Un Type Vrai

" et ne gérer que l'USB-C (et aller, Bluetooth et Wifi, parce que je suis sympa et parce que c'est sur l'iPad...)

Et que diable voudrais-tu supporter d'autre en 2017 ? (Hormis espérons le le TB3)

L'USB-C est enfin l'aboutissement d'un mouvement de convergence, la connectique universelle que l'on attend depuis des décennies

Pour le wifi et le BT tu délires encore, c'est trivial de le supporter de nos jours.

@awk :

Trivial de supporter le wifi et BT ?

Tant de belles phrases et de culture étalées durant de longues heures ( pourquoi ? )

Et nous sortir ça !

Bon...

@trackos

Si tu peux mettre en avant où se trouve le prodigieux défi que représente aujourd'hui l'intégration de ces technologies pour un fabriquant de PC ?

L'électronique assurant ces fonctions étant développée et produite par des tiers ... il ne reste que quelques enjeux de positionnement d'antenne assez bien maitrisé sur des objets de ce facteur de forme.

Oui c'est des questions de l'ordre du trivial dans les diverses problématiques que peut avoir à traiter un fabriquant d'ordinateur de nos jours.

@@Un Type Vrai

"Un peux comme les PC en 1998 qui avaient un port série, un port parallèle, un port pour le souris et un autre pour le clavier ...

Là où déjà le mac avait l'ADB et qu'Apple a remplacé "ça" par l'USB."

Et heureusement tu voudrais revenir en un temps où cohabiter une tétrarchié de connectique dédiés plus ou moins efficace ?

L'adoption de l'USB qu'Apple a porté fût un grand pas dans l'histoire de l'informatique, celle de l'USB_C un achevant du mouvement qui tient de la félicité.

@awk

Pour le moment l'usb-c c'est surtout une flopée d'adaptateurs pour pouvoir brancher notre matériel actuel. Sur qu'à terme ça va se tasser, mais actuellement entre l'adaptateur pour pouvoir brancher la clé usb, l'adaptateur pour brancher l'écran, l'adaptateur pour l'imprimante et même l'adaptateur pour le smartphone (tout le monde n'a pas un iPhone), c'est retour en 1998 ;)

À moins que tu décides de "tout racheter" ;)

@Laurent S from Nancy

Le progrès nécessite quelques sacrifices ;-)

C'est loin d'être la première fois que nous sommes amener à vivre une phase transitoire de ce type et il y a beaucoup à gagner ici.

"À moins que tu décides de "tout racheter" ;)"

Sur un horizon de quelques années c'est toujours ce qui se produit

@@Un Type Vrai

"Ceci n'est qu'un exemple focalisé sur la connectique.

On peut voir aussi l'abandon de librairies 3D (Metal uniquement, allez, à la limite, OpenGL), de système de fichiers, de protocoles réseaux, ... Apple fera sa tambouille et vous adorerez être frustrés.

Et du procès d'intentions, pour la frustration c'est visiblement le moteur de tes délires car je ne vois pas comment qualifié autrement cette accumulation d'inepties ne reposant sur rien.

@@Un Type Vrai

C'est la suppression du Jack sur ls iPhone qui te met dans cet état ?

C'est toujours triste de voir de la rancoeur s'exprimer ainsi et obstruer l'esprit.

Je n'ai AUCUNE rancoeur.

Retourne lire mon post avec un esprit sans substance, tu nous a moisi le débat avec tes idée de "je représente le bien et je dois combattre le mal même là où il n'y en a pas".

Je n'ai pas d'iPhone et je me contre fiche du port Jack.

Par contre lorsque l'iMac est sorti il n'avait pas l'indispensable ADB et ce fût pourtant l'ordinateur le plus vendu 2 ans de suite...

@Un Type Vrai

Comme dit plus haut c'était juste une hypothèse, j'essais de comprendre comment on peut en arriver à proférer des trucs de cet acabit, rien de plus ;-)

@Un Type Vrai

Pour finir sur une touche positive.

L'USB-C malgrés son relative manque de maturité est la meilleur chose qui soit arrivé depuis l'apparition de l'USB

Un seul format de connections pour tous les usages et tous les périphérique sans compromis de performance, c'est un fantasme dont je n'osais rêver quand je jonglais il y a quelques décennies avec de monstrueux connecteurs exotiques et souvent peu efficace.

Et cette transition n'est en rien une volonté isolée d'Apple, c'est un standard largement partagé que tous les acteurs du marché adoptent.

La période de transition va demander quelques efforts mais le jeu en vaut largement la chandelle, c'est une libération, j'en ai une demi molle rien que d'y penser :-)

Je ne comprend pas comment on peut rechigner devant un tel événement jubilatoire : un seul connecteur pour tout.

"Je ne comprend pas comment on peut rechigner devant un tel événement jubilatoire : un seul connecteur pour tout."

Peut être parce que qu'on nous fait le coup depuis le début de l'informatique.

Un seul connecteur pour tout, mais pendant 3 ou 4 ans jusqu'au suivant où il faudra à nouveau tout changer...

Dans la vraie vie, un ordinateur utilisable a plusieurs génération de connecteurs.

@macinoe

"Peut être parce que qu'on nous fait le coup depuis le début de l'informatique."

Trés loin s'en faut, c'es une étrange interprétation du processus qui a petit à petit conduit à réduire la diversité des connectiques.

Ce qui se passe avec l'USB-C est un aboutissement qui n'a pas de précédent, c'est la première fois qu'un connecteur permet de supporter quasiment tous les besoins. Ce n'est pas rien.

"mais pendant 3 ou 4 ans"

Là encore il faut pas raconter n'importe quoi le facteur de forme de la connectique USB est resté rétro compatible de 1996 à nos jours soit 20 ans.

L'USB-C est la première rupture en 20A ans et il y a de grande chance quelle soit là pour longtemps.

"Dans la vraie vie, un ordianteur utilisable a plusieurs génération de connecteurs."

Sur un desktop, mais sur un laptop c'est moins évident

Au final ce n'est qu'un moyen de retarder l'inévitable

C'est croire que les choses sont figées et que les normes n'auront pas évolués dans 5 ou 10 ans qui est pour moi d'une grande naïveté.

Quand j'achète un ordinateur, je l'achète pour l'utiliser aujourd'hui, dans un contexte précis avec les contraintes de l'environnement du moment.

Pas en me disant que peut-être dans 2 ans, si tout va bien, je pourrais éventuellement profiter de sa connectique, avec un peu de chance et juste avant qu'il ne devienne complètement obsolète.

J'ai un laptop au boulot qui a des choses aussi modernes que de l'usb c et support des SSD M2,

Ça ne l'empèche pas d'avoir aussi des vieillerie comme un prise VGA..

Et bien cette prise elle m'a sauvé la mise de nombreuse fois chez des client qui n'avaient qu'un projecteur à cette norme.. et ce n'est qu'un exemple parmi de nombreux.

J'aurais eu bonne mine avec une unique prise usb c..

Un ordinateur c'est outil. Si il n'est pas utilisable ici et maintenant, c'est un mauvais outil, c'est tout.

@macinoe

Je crois pas prendre de risque en disant que le facteur de forme de l'USB-C est là pour longtemps

D'autant plus qu'il y a une nette différenciation pour une fois entre la norme physique et les protocole ce qui permet déjà une grande "versatilité" et assure une capacité future d'adaptation aux évolutions des usages.

Pour le reste il y a évidement toujours des périodes de transition, mais celle-ci est on ne peut plus excitante quant aux perspective quelle ouvre à un horizon de 4/5 ans.

J'ai entendu exactement le même discours à propos du thunderbolt en 2011...

On voit ce que ça a donné.

L'USB c a beaucoup plus d chance de s'imposer, mais ça ne change pas le fait qu'il faudra du temps et qu'actuellement une machine disposant uniquement de ce port est inadaptée à la réalité et qu'au mieux, c'est pari. Un pari qui, si tout va bien sera gagné une fois la machine complètement obsolète.

@macinoe

Comme tu le remarques toi même la comparaison est un rien déplacé.

Le TB, au delà des discours marketing, n'a jamais été porté par un large groupement d'acteur de l'industrie ... il était assez clair des le départ que ce serait une norme de niche.

Pas grand chose à voir, de mon point de vue, avec la situation de l'UCB-C, non ?

"mais ça ne change pas le fait qu'il faudra du temps et qu'actuellement une machine disposant uniquement de ce port est inadaptée à la réalité et qu'au mieux, c'est pari. Un pari qui, si tout va bien sera gagné une fois la machine complètement obsolète."

Qualifier l'USB-C de pari me semble un peu exagéré, c'est largement adopté par l'industrie la transition est inévitable et elle est très loin de n'être que le fait d'Apple.

Pour l'inadaptation aux réalités, je serais moins dans l'outrance que toi : à certaines réalités me semble bien plus juste.

Après d'une part c'est quand même assez facilement contournable à des coûts raisonnable dans la majorité des cas et pour les Desktop il y a de grande chance que durant un temps les deux formats d'USB soient supporté .

Pour Apple par contre il y a de grande chance que comme à son habitude depuis des décennies elle fasse table rase de l'héritage.

Perso. Je vois 4-5 message de toi et j'arrête de lire la suite. c'est sans fin.

Moi il y a un truc qui me fait rire depuis plusieurs jours.

On parle beaucoup des pseudo-professionnels sur le fil des commentaires et dans ce cas, on a awk qui se positionne en tête de liste.

Allez sur les 290 commentaires, tu dois en avoir au moins un quart si ce n'est pas plus à son nom. En plus d'être condescendant (le pauvre, on lui a appris à écraser les autres, ne lui en voulez pas). Il n'a pas de vie, il passe son temps sur macg (regardez les horaires de publication c'est juste magique) pour répondre à tout le monde parce que vous comprenez, c'est lui qui a raison. Et en plus pour quelqu'un capable de faire des superbes citations avec des discours pompeux au milieu de pavés creux, vides d'intérêt et souvent remplis d'attaques personnelles visant à humilier les autres, il ne sait même pas écrire dans un "franssé correcte", j'ai les yeux qui saignaient tout le long du fil !

Même mon fils fait moins de fautes que toi !

Donc awk, redescend sur terre, apprend l'humilité (parce qu'effectivement tu as pas l'air si con) et respecte les autres, tu seras respecté (une citation de moi-même).

Sort un peu de cette condescendance paternaliste où tu passes ton temps à distribuer les points et montrer "ouais moi je sais" "ta gueule, j'ai raison, mais toi t'es con".

C'est juste insupportable !

Je connais beaucoup de collègues qui sont comme toi, et c'est insupportable et ils ne finissent jamais bien.

C'est un vrai conseil que je te donne la, je ne cherche pas à être méchant avec toi, mais la j'en ai marre de ce site, à cause de personnes comme toi, après les sites anglophones me vont mieux de toute façon.

@Manubzh

"C'est un vrai conseil que je te donne la, je ne cherche pas à être méchant avec toi,"

Je ne le prend pas comme une attaque et je comprend ta position.

Après tu te trompes sur mes motivations mais tu as parfaitement le droit de percevoir les choses ainsi.

"au milieu de pavés creux, vides d'intérêt "

Là c'est bien plus discutable :-)

Si tu prends l'ensemble de mes échanges il y a beaucoup d'informations de valeurs qui sont proposées et discutées.

Et une proportion de bêtises largement en deçà de la moyenne :-)

En général je traite les sujets que je connais et où j'ai des éléments de valeur ayant de solides fondation à partager.

Pour le reste nous sommes sur un sujet qui me tiens à coeur et qui me passionne d'où mon implication sur ce fils de commentaire.

Enfin il y a là défense du credo de l'ineptie de l'hybridation des paradigmes d'IHM où effectivement je suis radical :-)

Dernier point, j'ai toujours la faiblesse de croire qu'aider une personnes à voir la faiblesse de ses connaissances et de ces propos et le premier pas vers l'enrichissement, ce qui est évidement hélas rarement le cas tant beaucoup sont droit dans leur bottes et leur outrecuidance à surestimer leur niveau de connaissance.

Il ne s'agît pas d'écraser l'autre, ce serait une piètre victoire en ces lieux, mais de lui donner la possibilité d'élargir ses horizons et de se créer de réelles compréhension su sujet.

Ma démarche est altruiste et bienveillante :-)

Face à la bêtise je ne me sent jamais supérieur, mais juste attristé.

@Manubzh :

Franchement tes jugements sont dignes de Donald Trump face à Hilary Clinton .

Du haut niveau ....

"au moins un quart si ce n'est pas plus à son nom. "

On est à 40% avant que je pose mon commentaire.

@françois bayrou :

Ne me dit qu'il y aura un second tour ?! En nombre de mots il doit gagner haut la main

@françois bayrou

Mon cher François cette implication est propre à ce fil et à ce sujet qui me passionne et me tient à coeur

Avec en prime la sainte lutte contre les attaques de la doctrine que sont les concepts foireux d'hybridation s :-)

Le seul point vraiment négatif du passage à l'ARM serait de ne plus pouvoir virtualiser WINDOWS avec des performances on va dire normales. J'ai un très mauvais souvenir de la virtualisation de Windows à l'époque du PowerPC. Malheureusement, Windows j'en ai encore besoin...

@inumerix

C'est effectivement une des limites claires de la potentielle démarche avec en corolaire la disparition de Boot Camp.

La nécessité du support de Windows est sans doute moins forte qu'elle ne l'était il y a une dizaine d'années pour Apple, mais elle n'en reste pas moins importante pour pas mal de monde.

A titre personnel je ne vois pas une transition aussi globale que celle qui se fît lors du passage du PowerPC au x86 où toute la gamme bascula en une petite année.

La donne de l'époque semble rendre envisageable la cohabitation de deux architectures dans l'offre sans grandes conséquences.

@awk :

Pas une transition aussi globale, ouah, mais dit donc t'en enfonce des portes ouvertes...

@trackos

Pas si ouverte que cela au vue des commentaires d'autres contributeurs ;-)

Et loin d'être évident ou garanti, c'est une hypothèse pas une certitude comme tu sembles le croire.

De plus le point que j'avance c'est la possibilité d'une cohabitation de l'offre sur du long terme, qui est loin d'être évidente et certaine.

Bref, la critique pour faire le malin ça ne mène jamais bien loin :-(

Il y en a qui prennent des risques dans la vie, je vous dit pas !

@awk :

Mais les autres contributeurs non rien à voir, on va peut-être les laisser tranquille, non mais !

Et puisque l'hypothèse est probable comme tu dis c'est qu'en l'avançant on ne prend pas trop de risques ( ce que j'ai à peu près dis )

Et du coup parce que je dis que tu ne nous avance à rien je critique pour " faire le malin "

Sinon t'as qu'à faire avancer le débat plutôt, non ?

Parce qu'avancer qu'un vrai pro veut ses lignes de codes ça c'est fort, ça ne veut rien dire le terme pro, il y a trop d' utilisations possibles ( et certains qui utilisent fortement leurs machines le font sans taper une ligne de code )

@trackos

"Sinon t'as qu'à faire avancer le débat plutôt, non ?"

Si tu prenais la peine de lire le fil ...

"Parce qu'avancer qu'un vrai pro veut ses lignes de codes ça c'est fort, ça ne veut rien dire le terme pro, il y a trop d' utilisations possibles ( et certains qui utilisent fortement leurs machines le font sans taper une ligne de code )"

????

Je ne vois pas à quoi tu fais référence ?

A moins que ce ne soit à ma saillie ironique sur le VT52; VI et Emacs que tu aurais pris au premier degrés ?

Je me moquais justement de l'abus de langage du terme "PRO" qui ne veut strictement rien dire dans le propos de beaucoup, pour qui un PRO c'est celui qui fait le même métier que lui :-)

Si non je ne vois vraiment pas

@awk :

J'ai lu le fil et c'est vrai que grâce à toi maintenant on en sait beaucoup plus sur la stratégie d'Apple et des changements qui vont survenir.

On sait même ce qu'on doit acheter en fonction de nos besoins sans se soucier d'une éventuelle obsolescence prématurée des macs...

Ah bah non en fait !

@trackos

On sait même ce qu'on doit acheter en fonction de nos besoins sans se soucier d'une éventuelle obsolescence prématurée des macs..

Tu peux résumer mes propos ainsi mais cela me semble très réducteur pour le moins :-)

Il me semble que nous avons, avec d'autres, abordé et débattus bien plus de questions sur ce fil et sur son pendant traitant du même sujet.

Nous avons même essayer de faire de la vulgarisation sur le concept d'architecture de CPU avec un de nos camardes qui en avait fait la demande.

Beaucoup de considérations, techniques, stratégique, marketing ... ont été abordées c'est plutôt vaste et riche.

Par exemple moi je ne fais pas avancer le débat mais j'envoie pas 15000 messages ( et je n'ai aucune prétention ( en même temps je ne peux pas))

Je pense que ça a une certaine logique, accompagnant d'autres grand chantiers comme le nouveau système de fichiers et le recodage de macOS en Swift. Ils le sortirons quand ils jugerons les performances "suffisantes" (à leurs critères).

@Myka31

Tu sais ce type le moteur de ce type de démarche repose bine plus sur des enjeux stratégique et commerciaux que sur l'avancement de chantiers techniques tel ce que tu évoques.

Swift n'a pas grand chose à voir dans l'affaire.

Pas plus qu'AFS

Quant au "recodage de macOS" que tu évoques, je ne vois pas de quoi tu veux parler, un tel chantier n'est pas dans les tuyaux à première vue.

D'ailleurs si monsieur voulais bien axer ses discours là dessus cela ferait grand bien aux néophytes très présents ici ( dont je fais partie )

Enfin si ce n'est pas trop demander s'entend

@trackos

"axer ses discours là dessus"

Je veux bien mais sur quoi ? Précises ;-)

" aux néophytes très présents ici ( dont je fais partie )"

Il n'y a aucune honte à être néophyte et c'est même très respectable de le savoir et de l'assumer (C'est relativement rare en ces lieux en fait)

@awk :

Un gars s'inquiétait d'un achat récent ( bon, il est vrai que tu es intervenu en le rassurant ) mais bon, c'est navrant les tournures que prennent les discussions sur ce forum ( on ne va pas refaire le monde c'est vrai ) et du coup on s'éloigne du sujet.

Pour ma part, c'est pas l'architecture du cpu qui s'oppose à l'achat d'une bête pareil mais un problème bien plus simple, le budget !

Pages