Apple ferait construire des serveurs destinés à l’IA avec ses puces Apple Silicon 🆕

Mise à jour le 07/05/2024 à 08:08 : le Wall Street Journal ajoute sa voix aux rumeurs liées aux serveurs conçus par Apple, avec une information toutefois un petit peu différente. D’après le journal, Apple concevrait des puces spécifiques pour ces serveurs, des puces optimisées pour l’intelligence artificielle. Le projet serait nommé en interne ACDC, pour « Apple Chips in Data Center » (des puces Apple dans un centre de données).

Article original

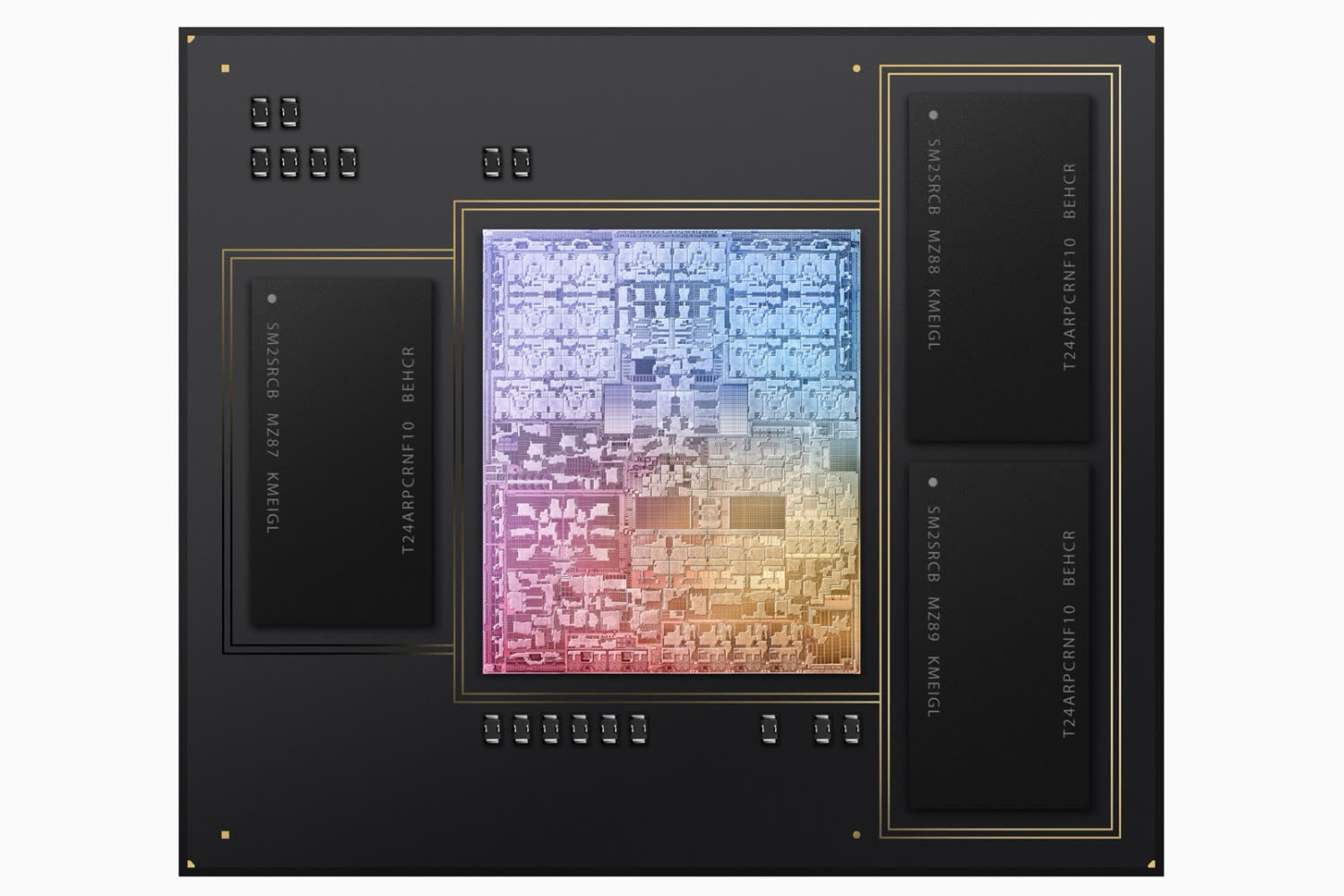

D’après Jeff Pu, Apple aurait demandé à Foxconn de produire des serveurs destinés à son propre usage. Ces ordinateurs seraient construits en ce moment autour d’une puce Apple Silicon, actuellement une M2 Ultra selon l’analyste, qui ajoute qu’Apple aurait prévu une nouvelle génération basée sur une future M4 pour fin 2025. Ces serveurs ne seraient pas à vendre, il s’agirait uniquement de remplir les centres de données gérés par l’entreprise de Tim Cook et ils serviraient dans le domaine de l’intelligence artificielle.

Ce n’est pas la première rumeur qui évoque la possibilité d’un retour des serveurs avec une pomme. Il y a quelques semaines, une source évoquait la même idée sur Weibo, parlant alors d’une machine prévue pour 2025 et basée sur une gravure à 3 nm de TSMC pour la puce principale. Si l’on croise les deux informations, il s’agirait vraisemblablement de la deuxième génération basée sur une puce M4.

Ces serveurs pourraient à terme permettre à Apple d’offrir des fonctionnalités similaires à celles de ChatGPT ou Gemini avec ses propres outils, en maîtrisant la chaîne d’un bout à l’autre. Pour rappel, les bruits de couloir semblent indiquer qu’en attendant, l’entreprise ferait appel à Google ou OpenAI pour offrir l’IA plus avancée, celle qui ne peut pas (encore) tourner localement sur nos appareils.

IA : Apple envisagerait d’inclure Gemini et non son propre modèle de langage dans iOS 18 🆕

iOS 18 : Apple aurait repris ses négociations avec OpenAI

À moins qu’il ne se soient fournis en serveurs dédiés ia ailleurs en attendant (ce qui serait étonnant de la part d’Apple), cette news est la confirmation qu’Apple n’a jamais entraîné d’IA elle même jusqu’ici… 😩

La WWDC sera bien décevante : probablement une série d’annonces de collaborations avec les ia actuelles et des promesses pour l’avenir :/

Peut-être qu’une ia locale sera là juste pour faire des résumés (youpi) et améliorer quelques fonctions images et un Siri moins idiot

Mais si ça tombe on sera tous bluffés par une annonce qu’on attendait pas 🤩

@lienmathieu2

Ben si l’IA peut masquer en local les commentaires stupides (pas le votre, en général), ça sera une grosse avancée déjà.

@lienmathieu2

Il y a l’IA niveau ChatGPT 4, et Apple n’en n’a probablement pas (parce que ils sont en retard sur tous les indicateurs, et que ça se crée pas en claquant des doigts et du fric), et n’a certainement pas les infrastructures pour l’ouvrir à sa base de 1 Md de clients.

Et il y a l’IA locale, et elle sera annoncée dès demain, mais faudra attendre pour voir si elle est ridicule ou sert à quelque chose parce que bien intégrée dans l’OS.

@hugome

Dès demain? Il me semble qu’il n’y aura aucune annonce côté IA demain mis à part peut-être une puce M4 boosté pour ça…

@redchou

Ben voilà.

@hugome

Ça n’a rien de nouveau du côté IA locale, c’est juste que le Neural Engine du SoC (qui est déjà présent dans toutes les puces Apple depuis longtemps) serait plus fournit…

@redchou

Je dis juste qu’Apple annoncera aujourd’hui que leur iPad est en pointe pour l’IA locale grâce à sa nouvelle puce qui permettra de faire des miracles. Bien sûr, ça voudra pas dire grand chose de précis.

@hugome

Ben oui ! Ils sont « en retard » !

En retard de quoi ? Entraîner un IA ? Apple ne va pas créer un deuxième ou troisième ChatGPT !

Apple reste maître des horloges. Et, avec tout le respect que je te dois, j’ai un peu plus confiance en la suite que ne laisserait penser ton commentaire de pseudo spécialiste.

@Malouin

"En retard de quoi ? [...] Apple reste maître des horloges"

Je suis assez d'accord avec votre remarque. Je me souviens encore des commentaires très critiques du le retard qu'Apple prenait sur les services de la téléphonie mobile...

et puis ils ont sorti l'iPhone.

@Malouin

J’ai déjà essayé de lui expliquer ça mais je me suis fait taxer de fanboy en réponse 🤷♂️

@Nico_Belgium

Réponse traditionnelle…

@Malouin

Pareil que vous je suis exaspéré par ces commentaires qui ne cessent de dire qu’Apple est en retard sur le sujet. Leur angle de R&D sur le sujet n’a clairement pas été celui de Open AI et aujourd’hui n’ont pas de service équivalent et alors ?

Déjà je ne suis pas certains que les utilisateurs et utilisatrices à qui cela fasse défaut soient majoritaire, donc niveau urgence on repassera, et d’autre part si l’on regarde ce nouveau marché on voit des nouveaux acteurs comme Mistral qui arrivent parfois à faire jeu égal avec GPT 4… La stratégie ? Des énormes levées de fond. Le nerf de la guerre se situe en bonne partie sur la capacité d’investissement de l’entreprise, qu’à cela ne tienne Apple est assis sur un tas de cash monumental …

Qu’ils aient loupé un virage j’en conviens, mais si l’on était sévère on pourrait dire que leur situation pourrait faire penser à celle de Microsoft avec le smartphone à la fin des années 2000. La différence c’est qu’à priori personne chez Apple n’a perdu de temps à dévaluer les IA génératives et finalement se sont mis au boulot relativement rapidement. Bien du monde se moquait du Microsoft de Ballmer puis l’entreprise a su revoir sa stratégie et redevenir plus pertinente dans ses choix jusqu’à devenir de créée une position de choix dans la concurrence des AI.

Pour conclure mon point serait le suivant : nous ne sommes qu’au prémices d’un développement technologique intensif, les cartes sont amenées à être rebattu sans cesse encore pendant quelques années, Mistral en est un bon exemple. Le développement des AI coûte extrêmement cher et pour le coût Apple a une capacité d’investissement à son avantage que bien d’autre n’ont pas. Donc il est prématuré de tirer des conclusions sur la place d’Apple sur ce marché à long terme.

@Lecorbubu

C’est là que tu te trompes.

Des équipes du niveau de Mistral, qui en passant étaient chez Google Mind avant, il n’y en a pas sur le marché, et les meilleurs jusqu’à présent n’étaient pas chez Apple.

Et la comparaison avec Microsoft, elle est pertinente, mais elle ne va pas dans ton sens. Malgré tous ses milliards, M$ a été éjecté du marché du smartphone comme une vieille chaussette.

@Lecorbubu

« Pareil que vous je suis exaspéré par ces commentaires qui ne cessent de dire qu’Apple est en retard sur le sujet. »

Personne d’entre nous ne sommes dans les petits papiers d’Apple. Personne d’entre nous n’est Mark Gurman. On est sur un forum de gens passionnés d’Apple qui ne sommes pas super informés et on spécule, c’est normal :)

Être optimiste ou pessimiste sur le retard ou l’avancement d’Apple n’a pas plus de valeur l’un que l’autre.

On peut juste écouter et essayer d’interpréter.

- Bertrand Serlet (à la retraite j’en conviens, mais il a engagé Craig Frederighi, et reste une personne qui s’y connaît un peu plus que nous) a énoncé dans des interviews qu’il était inquiet du retard pris par sur l’ia et sur le rythme de développement annuel à la manière d’Apple qui ne convient plus à l’accélération actuelle. Voire cette interview à partir de 1:00

https://youtu.be/WjaOrtsqj9A?si=tudQsG75shF2DSvG

Cessons de dénigrer l’avis de l’autre et discutons calmement (on est tous mal informés de ce qui se passe chez Apple même si certains connaissent mieux ici le dev IA que d’autres. Même les devs d’applications Apple n’ont pas plus d’informations que ce qui ne sort dans la presse).

Mon avis est que chez Apple; on travaillait depuis des années avec des outils d’intelligence artificielle pour l’image, dont chaque année on avançait calmement en annonçant de petites améliorations…

Mais au moment de la sortie de ChatGPT, Apple n’avait RIEN appliqué au langage. Depuis c’est la panique. Depuis ils ont probablement créé une équipe d’urgence (« Big Tent » team, comme le dit Gurman). Je vois mal comment ils auraient pu rattraper facilement alors qu’il y a un développement effréné chez OpenAI et Google. L’ia langage locale d’Apple est un moyen de commencer sans paraître trop ridicule, mais ce sera juste des fonctionnalités de siri améliorées (avec aussi la possibilité de pondre des résumés, pour faire une belle démo lors de la wwdc) dans un premier temps. Du coup ils font des accords. Ce qui est rare pour Apple. Voire Tim Cook réclamer un dîner avec Sundar Pichai a dû être un gros contraste avec ce qui s’est passé ces dernières années.

Mais ce que Serlet dit dans son interview ci dessus, c’est que le cycle d’annonces annuelles à la WWDC est bien trop lent pour le contexte de développement actuel.

La nouvelle ia locale ou le nouveau Siri devrait être mis à jour beaucoup plus souvent que les lentes mises à jour d’iOS.

@lienmathieu2

Merci pour ce commentaire exhaustif et constructif. J’avais regardé la vidéo que tu cites ici, comme la très grande partie des émissions ORLM depuis 2010 pour lesquelles j’ai une très grande sympathie même si je ne suis pas toujours alignée sur certains de leurs points de vue.

Dans le cas de l’IA au travers des émissions regardés ils rejoignent majoritairement l’avis de leur invité à l’exception de Laurent Pantanacce. Au delà de ORLM tu as raison qu’un mec comme Serlet a sans doute plus de bagage que nous tous pour fonder son avis.

De mon côté ma perception, subjective et de fait peut-être erronée, tend à penser que l’ère de l’IA n’en est qu’à ses débuts et qu’il est trop tôt pour présumer de qui en sortira vainqueur ou perdant. Comme tu l’as expliqué il semblerait que le virage ait été loupé par Tim Cook et ses équipes. Maintenant il semblerait que ça s’active sérieusement en interne.

Si l’on prend plusieurs grands moments de la tech on peut voir que le plus visionnaire n’aura pas forcément été le plus récompensé commercialement : Microsoft a allègrement copié le Macintosh et son interface graphique (issus de XEROX à la base) et très rapidement les PC auront pris le lead. On peut dire la même chose avec Android, qui au lendemain de la présentation du premier iPhone avait compris qu’ils étaient à la ramasse, voir lien (désolé je n’ai pas trouvé mieux que le journal du geek pour relayer les propos des intéressés …) : https://www.journaldugeek.com/2013/12/21/google-concu-android-reaction-iphone/

Pour les smartphones toute l’industrie a copié le form factor de l’iPhone, Samsung le premier, et cette stratégie lui aura permis de rester dans la course depuis, encore aujourd’hui.

À mon sens il y aurait une vraie raison de s’inquiéter si Apple ne reconnaissait pas l’importance du moment, à l’instar d’un Steve Ballmer qui dénigrait l’iPhone à sa sortie, une décision stratégique qui je pense aura laissé définitivement Microsoft sur le carreaux sur le marché du smartphone. Le dernier gros virage technologique qu’a été celui du smartphone est très instructif, on voit bien que les entreprises qui ont été dans le dénis se sont ramassés copieusement. Un acteur comme BlackBerry en est un autre exemple, ils étaient convaincus que le public voudrait toujours le clavier et qu’il y aurait toujours une place importante pour ce modèle de téléphone ce qui a manifestement été une erreur d’appréciation du marché mais surtout une peur d’interroger ce pourquoi leur produit était plébiscités.

Dans les cas cités on a à la fois une carence dans la vision prospective, un retard technologique et surtout une absence totale de prise de conscience à l’instant où une innovation majeure se déploie. Et c’est a mon avis ce moment qui peut s’avérer fatale si mal pris en compte.

@Malouin

Bien sûr que si ils vont essayer de créer un bot interactif intelligent.

Ça fait dix ans qu’ils essaient, il s’appelle Siri.

Est-ce qu’il sera au niveau de chatGPT 4, non, et c’est bien leur problème

Est-ce qu’il deviendra meilleur avec le temps, forcément.

Est-ce que la v1 qu’on aura en fin d’année sera acceptable ?

Ben on verra. Apple nous inondera de marketing pour nous dire que oui, et plein de gens ici diront que c’est génial. Dans les faits, peu de gens seront capables de faire une évaluation sérieuse avec la concurrence, toutes choses égales par ailleurs

Je répète ce que j’ai écrit déjà 10 fois, et qui est juste du bon sens pour qui sait compter: il y aura une IA locale Apple, mais elle ne sera pas au niveau des meilleures IA sur serveur du marché.

Et Apple cherchera probablement à offrir une IA distante, raison pour laquelle ils discutent avec OpenAI et Google, mais quelqu’un devra payer pour ce que ça coûte (cher). Et je pense que si ça se fait, ça sera le client Apple dans une solution de service packagée à la iCloud+

@hugome

Ils ne sont pas forcément en retard sur GPT 4, peut-être que c’est juste la version qui devrait tourner en local sur iphone qui demande encore trop de puissance ? Sinon en effet, entraîner le modèle ne demande certainement pas autant de serveurs que de le proposer à des milliards d’utilisateurs.

@gbasile

Ils ont deux à trois ans de retard sur les meilleurs du monde, ça se rattrape pas en lançant des programmes d’action et en souriant à la presse.

Le point c’est surtout que l’IA locale, qui correspond au business model d’Apple, ne pourra jamais battre un serveur dont les besoins de chargement en RAM pour faire tourner le modèle gpt4 et répondre rapidement semblent se mesurer en centaines de Go

@hugome

Apple n’a jamais annoncer qu’il ferait un LLM non plus.

@bitcoinmypocket

Ils seront obligés de faire un assistant efficace en langage naturel, les gens ne vont plus supporter le dinosaure Siri longtemps, et aujourd’hui ça passe par un LLM et ça devrait passer en local. Par contre, on sait pas quand ils seront prêts. ça m’étonnerait qu’ils aient rien du tout fin 2024, au moins sur les iPhone Pro. A minima, si le hardware n’est pas prêt, ils vont faire semblant

Ça veut pas dire qu’il feront en interne un service généraliste au niveau de chatGPT, ni même en marque blanche, on est d’accord

@hugome

Encore un commentaire d’un champion qui SAIT si une entreprise est en avance, en retard ou dans les temps sans communication officielle, sans y travailler, sans être dans le service de la boîte qui gère ça, bref, sans rien.

C’est au mieux une croyance, au pire de la bêtise. Mais faut arrêter de dire qu’Apple est en retard avec l’IA puisqu’ils n’ont pas encore présentés leurs projets. Attendons la WWDC pour se faire un avis.

Avec autant de clairvoyance les personnes comme vous doivent être super riche grâce a la crypto et à la bourse.

@Bounty23

Avant d’insulter les gens que tu ne connais pas sur un sujet que tu ne comprends pas, lis ce qu’ils écrivent.

@hugome

Pas besoin non plus d’un LLM de plus aussi. Une intégration avec ce qui existe déjà suffirait.

Par contre de l’ia dans les apps native la oui.

@bitcoinmypocket

Pas besoin d’un ChatGPT de plus, non, mais c’est une belle opportunité de croissance dans les services, et Apple ne va pas abandonner sans se battre.

@ lienmathieu2 : « cette news est la confirmation qu’Apple n’a jamais entraîné d’IA elle même jusqu’ici… »

Mince… ils ont donc distribué des modèles sans les avoir entraînés… Les enfoirés ! 🤣

@BeePotato

Ils ont distribué quel(s) modèle(s) ?

@redchou

Ajax. On ne sait pas encore trop à quoi s’attendre.

@lienmathieu2

Si il a été distribué, il doit bien y avoir quelqu’un qui lui a fait passer les benchmark classique? Ou un minimum testé comparativement à la concurrence…

@ redchou : « Ils ont distribué quel(s) modèle(s) ? »

Ben les divers modèles inclus dans leurs OS pour les fonctions d’IA qui y sont présentes (et se multiplient) depuis plusieurs années, notamment autour des images (il n’y a pas que les LLM dans la vie).

Et puis d’autres aussi, en dehors des OS. Par exemple OpenELM, récemment.

https://huggingface.co/apple

@BeePotato

Oui, rien qui ne nécessite une puissance de dingue ou une infrastructure de folie.

Ils ont très bien pu utiliser un service type Azure ou autre pour les entraîner… C’est dans ce sens que je comprends le commentaire de base.

@ redchou : « Ils ont très bien pu utiliser un service type Azure ou autre pour les entraîner… »

Tout à fait, ça sert à ça.

Ou ils ont très bien pu utiliser un stock de serveurs à eux (serveurs classiques avec des GPU Nvidia — je ne parle pas de serveurs avec puces Apple) dans une de leurs installations. On ne sait pas.

« C’est dans ce sens que je comprends le commentaire de base. »

Moi pas. Le commentaire de base disait : « cette news est la confirmation qu’Apple n’a jamais entraîné d’IA elle même jusqu’ici ». Et c’est juste faux — ça ne confirme absolument rien.

@BeePotato

Ok.

@BeePotato

Ce serait chipoter sur le sens des mots, mais..:

« Elle-même est un pronom personnel qui permet d'insister sur le pronom personnel elle. Elle-même permet de marquer l'importance, mettre en valeur, amplifier les actions de la personne à laquelle il se rapporte.

Exemple : C'est elle-même, toute seule, qui a fait ce gâteau. »

En passant par un prestataire cloud, ce n’est pas Apple, toute seule, … ☺️

@ redchou : « En passant par un prestataire cloud, ce n’est pas Apple, toute seule, … ☺️ »

Ben si.

Que les machines soient achetées ou louées, ça ne change rien à qui fait tourner des trucs dessus.

@BeePotato

Ils ne distribuent pas de LLM j’ai l’impression.

Ou alors « Ajax », et c’est révolutionnaire à la manière de GPT. Mais on ne se pas avec quelles données ni quel matériel il a été entraîné du coup. Sûrement pas des cartes graphiques dédiées :)

@ lienmathieu2 : « Mais on ne se pas avec quelles données ni quel matériel il a été entraîné du coup. Sûrement pas des cartes graphiques dédiées »

Ah ? Il a été entraîné sur quoi, alors ? Un boulier ? 😁

Blague à part : je ne suis pas sûr de ce que tu entends par « cartes graphiques dédiées ».

Si tu voulais dire « pas sur des GPU Apple », c’est en effet plus que probable. Mais Apple n’a pas eu besoin d’attendre de produire ses propres puces dédiées à ça pour travailler sur ses modèles. Ils ont simplement tourné sur du Nvidia, comme tout le monde.

Le montage est très bien fait 🙂👍.

@Gerrer

> "Le montage est très bien fait"

Même trop bien.

La partie mordue de la pomme indique une lobotomie sur l’hémisphère droit. Lobotomie concernant le lobe frontal, le lobe temporal et, probablement, un bout du lobe pariétal.

Ce qui cadre avec les comportements observés.

@occam

Ah moi je ne suis pas allez aussi loins mdr 😂 je trouvais juste le design super stylé. Prochaine étape : Macg qui deviens une boite de design ?

Une des grosses révolution de la fin du siècle /millénaire était la recherche internet, et en 2024 Apple n'a toujours pas de moteur de recherche et pourtant, ont-il raté la révolution d'internet pour autant ?

Ou plus tôt,la révolution de la PAO, Apple n'avait aucun logiciel de mise en page pro ou d'édition d'image..tout a reposé sur les technos d'Adobe. (Et Aldus et Quark etc), Apple fournissant le hardware.

Le plus important c'est comment sont intégré les technologies, quels en sont les usages et les avantages.

Vous vous souvenez des wwdc avec les présentations d'AR kit, depuis plusieurs années. Sympa mais sans réels applications concrètes. Puis un jour, paf on nous annonce le vision pro. Depuis 5/6 ans, Apple insiste sur les neural engine de ses processeurs, sans réel grosses application,puis depuis peu Le detourage automatique d'image, le texte en directs, etc... Tous les trucs et machins présenté depuis quelques années trouvent un sens dans des applications concrètes grand public. Bah peut être que pour l'IA générative, on va découvrir enfin à quoi servent tous les cœurs neuronaux dont sont équipés les iPhone et mac. Le hardware s'installant peu à peu, le software vont pouvoir l'exploiter.

Car Microsoft, en dehors de l'intégration d'open Ai n'a rien non plus en ia et pourtant l'intégration de chat gpt dans office et Windows s'annonce intéressante sur le papier. Sous réserve que l'ia, pour le grand public ne soit pas qu'une énième bulle.

On verra à la wwdc ce qu'ils vont nous présenter.

Très étrange, la M2 ultra est puissante, mais ce n'est rien côté IA comparé à ce qu'il se fait en puce custom sur le marché (Bon CPU, moyen GPU, correct NPU). Je ne comprend pas pourquoi Apple utiliserait ça dans un data-center

@Mrleblanc101

Parce qu’ils n’ont rien d’autre… L’avantage, c’est que la M2 Ultra peut avoir énormément de Ram, c’est très important pour l’IA.

@redchou

"Énormément", c'est rien dans le monde du data-center la RAM se compte en To

@Mrleblanc101

Y’a pas bcps de GPU avec 192Go de Ram. La mémoire unifiée des puces d’Apple permet d’allouer toute la Ram au GPU, équiper un serveur avec des To de Ram ne sert à rien dans le cas de l’IA, ce qui compte, c’est la quantité utilisable par le GPU.

@redchou

Le GB200 NVL72 de Nvidia monte à 13.5 To de HBM3 avec une bandwidth de 576 To/s lol

En plus de pouvoir être relié à 17 To de RAM

@Mrleblanc101

Hahaha mdr… Trop des lol 🤦♂️

C’est pas un GPU le GB200 NVL72 mais 72…

J’imagine que chez Apple, ils ne sont pas con au point de foutre un M2 Ultra dans l’espace d’une armoire même si c’est ce que, apparemment, tu penses.

@redchou

En effet, c'est une solution tout en un. Mais leur GPU torche le M2 Ultra, et même un hypothétique M4 Ultra

@Mrleblanc101

La dessus, il faudrait avoir plus de données.

( https://towardsdatascience.com/apple-m2-max-gpu-vs-nvidia-v100-p100-and-t4-8b0d18d08894 )

Mais avec les dernières avancées dans l’optimisation côté Apple, et si on ajoute l’utilisation d’un M2 Ultra dans la configuration qui était attendu avant l’annonce du Mac Pro, c’est à dire en x2 ou x4.

La solution d’Apple à l’avantage d’être disponible, contrairement à celle de Nvidia, où il y a des mois voir des années d’attentes. Et elle ne leur coûte presque rien comparativement à une solution vendu à prix d’or…

@redchou

« Trop des lol »

Jpp mdr 😂 Excellent. Ça me rappelle mes années collège. Merci pour ce moment de nostalgie 🙂👍.

Et ca doit leur couter 100x moins cher que les concurrents parce que contrairement a NVidia et leur clients, ils ne se volent pas eux meme avec des surcotes insultantes.

Pages