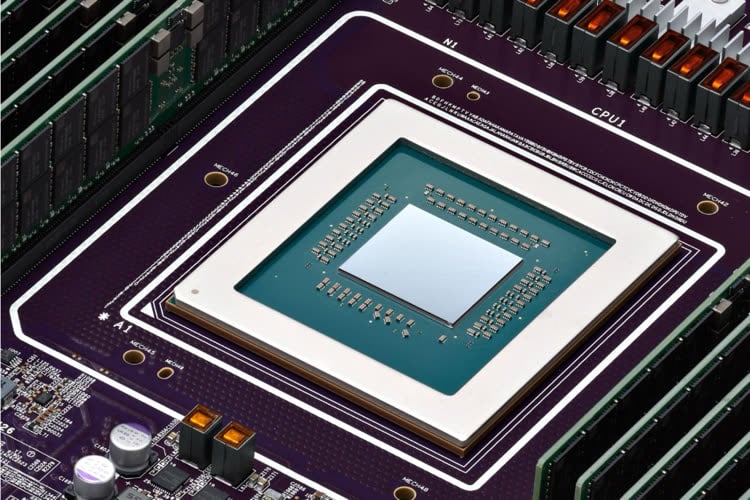

Apple pourrait développer une puce Apple Silicon pour les serveurs et l'IA

Les puces qui emploient le jeu d'instructions ARM ne se limitent pas à la mobilité et à quelques ordinateurs, nous en avons déjà parlé. Et selon une rumeur, Apple pourrait développer ses propres puces pour le domaine des serveurs et les calculs liés à l'IA.

C'est 手机晶片达人 (Phone Chip Expert en anglais) qui en parle sur Weibo, un réseau social chinois : Apple pourrait proposer ses propres puces dès 2025, avec une gravure en 3 nm. Ce n'est pas anodin : c'est un domaine important pour de nombreux acteurs, qui dépendent pour le moment beaucoup de Nvidia pour l'IA. Dans les CPU des serveurs, Intel et AMD restent les deux fournisseurs principaux, mais les puces ARM sont de plus en plus populaires, chez Amazon, Google ou même Nvidia, qui développe des systèmes sur puce pour les coupler avec ses cartes dédiées aux calculs IA.

Google a sa propre puce pour les serveurs, Axion

Dans le domaine des CPU, Apple a évidemment une carte à jouer avec ses cœurs basse consommation. En effet, dans les serveurs, la demande est un peu particulière : les centres de données ont besoin de puces avec de nombreux cœurs (pour gérer le plus possible d'utilisateurs) mais pas nécessairement d'une énorme puissance brute. Les cœurs basse consommation, qui sont physiquement compacts et consomment peu, sont donc parfaits pour cet usage quand ils offrent des performances décentes et Apple dispose d'une excellente expertise dans ce domaine.

Pour la partie IA, la donne est différente : Nvidia a une énorme avance sur ses concurrents avec des cartes qui ont une puissance brute extrêmement élevée et un environnement logiciel connu et efficace. Mais les cartes ont le défaut d'être onéreuses (comptez plusieurs dizaines de milliers d'euros) et de consommer beaucoup d'énergie. S'il est possible qu'Apple puisse s'approcher de Nvidia en proposant une sorte de NPU XXL1, il n'est pas certain que le but soit d'effectuer tous les calculs sur les serveurs : les dernières rumeurs indiquent qu'une partie des traitements se ferait en local.

iOS 18 : les nouveautés liées à l’IA se passeraient en partie du cloud

Nous ne pouvons donc pas spéculer réellement sur ce qu'Apple va proposer, tant les voies possibles sont nombreuses.

-

Et il faudrait ajouter un X pour faire bonne mesure. ↩︎

Je n'ai absolument aucun avis sur cette question mais il fallait impérativement que je vous le dise.

@ataredg

Moi j’ai enfin trouvé un ouvrage que je cherchais depuis très longtemps édité en 1972. Il fallait absolument que je vous le dise aussi !

@ataredg

"Je n'ai absolument aucun avis sur cette question mais il fallait impérativement que je vous le dise."

———-

Ne t’inquiète pas.

Les nombreux experts de pacotille de MacG vont te donner leur avis.

je pensais que les rédacteurs suffisaient à eux-mêmes pour ça

@ ataredg

On t'a reconnu Raymond D.

Cool, ils vont ensuite nous sortir un genre de MacOs mais pour serveur?^^

Pas trop tôt.

Si c’est calqué juste pour les besoins d’Apple, bon point pour eux.

Si c’était ouvert à nous tous, ce serait un bienfait pour le monde.

L’espoir meurt en dernier. (Mais il n’en meurt pas moins.)

Des serveurs Swift qui carburent à Apple Silicon : j’en rêve.

@ Florent Morin

> Des serveurs Swift

Je ne sais pas ce que vous entendez par là, mais un OS écrit en Swift, j'y crois pas une seconde.

Si Apple est bien en train de réécrire toutes ses apps en Swift, avec quelques déchets/régressions au passage, remplacer Unix par un truc en Swift me parait juste impossible, la tâche serait incommensurable, si tant est que ça soit possible dans l'absolu.

@ marc_os : « emplacer Unix par un truc en Swift me parait juste impossible, la tâche serait incommensurable, si tant est que ça soit possible dans l’absolu. »

C’est possible. Mais l’intérêt de passer du temps à réécrire une telle masse de code est toujours limité, quel que soit le langage de destination choisi.

C’est autant de temps ingénieur qui ne serait pas passé autre chose (nouvelles fonctions, résolution de bugs), et la réduction potentielle du nombre de bugs liée à un langage plus sécurisé risquerait bien d’être masquée par la création de nouveaux bugs au cours de la réécriture.

Les actions Apple vont remonter , ils ont trouvé leur relai de croissance long terme

Tiens donc, quand j'avais supposé la chose il y a quelques semaines, on m'a traité de fou et d'ignare ici.

Je crois que c'est quand on parlait de l'abandon de l'Apple Car et de son prototype avancé d'une puce faite de 4 SoC M2 Ultra...

Pour Nvidia, Apple rachète la boite et hop ….

Soyons fou 🤪🤪🤪

Apple vaut environ 2600 milliards en avril 2024, Nvidia 2000...

Apple sur avril 23-avril 24 a vu sa capitalisation boursière augmenter de 1,7%, Nvidia sur la même période + de 200%...

C'était encore possible il y a une année, maintenant Nvidia est bien trop gros pour Apple...

A voir la demande en composants IA pour les 5 prochaines années, mais il ne serait pas impossible de voir Nvidia dépasser tout le monde en capitalisation boursière.

D'ailleurs, le cas Nvidia est très intéressant, car ce qu'ils ont fait en bourse en une année, Apple, pourtant réputée être maîtresse en rentabilité, a mis 5 ans.

« C'était encore possible il y a une année, maintenant Nvidia est bien trop gros pour Apple... »

Non mais c’est quoi ces calculs… 🤦🏻♂️

@pacolapo:

Une boîte qui en rachète une autre, elle rachète les actions, soit en cash, soit en action, soit seule soit aidée par un consortium de banque via des emprunts.

Racheter une boîte qui vaut 500 milliards (Et même pas sur que ce soit possible sur de tel montant, le maximum jusqu'à présent étant 200 milliards) n'est pas la même que racheter une boîte qui en vaut 2000. Tout comme lancer un OPA sur une entreprise qui carbure comme jamais on ne l'a vu dans le monde de la tech, imagine la gueule de l'action si une OPA est lancé sur LE fournisseur des 5 prochaines années en IA.

Nvidia, si il fallait mettre la main dessus c'était il y a 2-3 ans, ou elle valait 10X moins qu'actuellement. Une OPA est juste impossible sur les gros groupes. Ce que n'était pas Nvidia il y a peu.

Après on pourrait parler de l'inutilité

@debione

"A voir la demande en composants IA pour les 5 prochaines années, mais il ne serait pas impossible de voir Nvidia dépasser tout le monde en capitalisation boursière."

Pourtant, ça fait un mois que l’action nvidia se gadine sévère, -10%. Ça ne donne pas l’impression d’une montée exponentielle. Au contraire, il semble que l’embellie nvidia soit derrière…

Mon avis très brièvement :

- Apple

- Serveurs

- IA

-> lol la blague.

Bonne nuit.

Je rejoins ton avis...

@fte : Je rejoins ton Bonne nuit.

@ataredg

"Je rejoins ton Bonne nuit."

Je rejoins ton rejointage.

On nous annonce le retour des XServes ?

❤️❤️❤️

@ Pierre Dandumont

en proposant une sorte de NPU XXL

Rappel : Le Neural Engine d'Apple, c'est déjà une « sorte de NPU ».

Mais curieusement la presse "spécialisée" n'en parle pas beaucoup, même dans ce genre d'article où pourtant ce serait bien le lieu et le moment d'en parler, car on pourrait imaginer que cette puce dédiée IA soit basée sur le Neural Engine. Mais non.

Pourquoi ? 😳

@ marc_os : « Rappel : Le Neural Engine d'Apple, c'est déjà une « sorte de NPU ». »

C’est bien pour ça que l’auteur a parlé de NPU, justement.

« Mais curieusement la presse "spécialisée" n'en parle pas beaucoup, même dans ce genre d'article où pourtant ce serait bien le lieu et le moment d'en parler, car on pourrait imaginer que cette puce dédiée IA soit basée sur le Neural Engine. Mais non. »

Ben si. L’expression « NPU XXL » fait précisément référence au Neural Engine, tout le monde l’a bien compris.

@ BeePotato

> L’expression « NPU XXL » fait précisément référence au Neural Engine, tout le monde l’a bien compris

Mais oui bien sûr, si vous le dites.

Donc vous savez lire dans les pensées de "tout le monde" ?

Je suis impressionné.

🤪

@ marc_os : « Mais oui bien sûr, si vous le dites. »

Disons que si j’avais voulu éviter tout raccourci, j’aurais écrit : tous ceux qui s’intéressent à la fois au sujet abordé par cet article et au Neural Engine savent que ce dernier est un NPU — ou sinon, auront fort probablement fait une petite recherche sur ce qu’est un NPU et auront vite appris que « Neural Engine » est le nom commercial d’Apple pour ses NPU — et ont donc compris que l’expression « NPU XXL » faisant référence à une variante du type de matériel qu’Apple désigne sous le nom de Neural Engine ; tout en comprenant aussi que l’expression « NPU XXL » est plus correcte ici étant donné qu’il n’est pas du tout garanti qu’Apple réutilise le nom « Neural Engine » pour ces hypothétiques puces, surtout si elles se révèlent être à usage interne uniquement.

« Je suis impressionné. »

Oui, moi aussi je m’impressionne régulièrement.

Il n’y a pas que ça qui m’impressionne, cela dit.

J’utilise déjà des serveurs ARM de chez Hetzner sans trop de problèmes. Sur Ubuntu, la plupart des composants à installer sont compilés ou compilables pour cette architecture et il y a même de plus en plus d’images docker qui le sont donc la bascule est vraiment transparente.

Les prix sont aussi inférieurs aux VPS x64 et j’imagine que la consommation énergétique est bien inférieure donc pas de raison de se priver.

https://www.hetzner.com/press-release/arm64-cloud

Cette histoire de puce ia Apple sur des serveurs me fait penser à ceci:

Sincèrement vous préférez quoi pour vos requêtes ia génératives?

- une version locale qui fait chauffer, utilise la batterie, fait lagger le multitâche de votre iPhone, et qui risque d’être lent et à côté de la plaque quand vous avez l’iPhone d’il y a 2 ans?

- une version serveur qui tourne sur des machines ultra rapides, qui renvoie en 5g rapidement une réponse optimisée sans utiliser les ressources localement.

La vie privée est selon moi un faux argument: il est tout à fait possible de crypter comme on le fait pour iCloud et recevoir la garantie que nos données personnelles sont protégées sur un serveur, de la même manière que nos donnés sont en principe protégées sur iCloud. De même pour un résultat personnalisé de l’entraînement d’une ia selon ses spécificités personnelles.

Aussi , croire que l’ia qui tourne en local est parfaitement safe point de vue vie privée est globalement faux. Il faudra se connecter à des services pour que cela soit utile. Il faudra l’entraîner et stocker le résultat de cet entraînement quelque part. Je vois mal devoir reentrainer son IA à chaque fois qu’on change de téléphone (pas aussi simple que de recréer une Face ID local). Un iPhone a une connexion internet 24/24; ce qui est en soit une vulnérabilité.

Aussi l’intérêt est nul si on fait des sauvegardes sur iCloud comme on sauvegarde nos iPhones.

@ lienmathieu2

> Sincèrement vous préférez quoi pour vos requêtes ia génératives ?

Ce que je préfère ? Rien.

L'IA « générative », c'est pour les faignasses incompétentes et certains patrons qui faute d'avoir le droit d'employer des esclaves voudraient bien remplacer aussi les postes de "créatifs" — et tant pis pour le plagiat et les droits d'auteur, on n'est pas à ça prêt.

@lienmathieu2

Les deux mon colonel!

@lienmathieu2

On aura les deux.

Une petite IA locale, sorte de super-Siri, aux performances réduites qui traitera les choses les plus simples, comme la correction de texte, l’organisation, la recherche en langage naturel.

Et une IA distante pour les trucs les plus évolués et les plus actualisés.

La question c’est de savoir si Apple sera au niveau pour le truc premium.

@hugome

Llama 3 a besoin pour tourner en local d’une rtx 3060 12 go de VRAM et 16go de ram. Au minimum.

Sincèrement quelles sont les « opérations simples » qu’on va faire en local sur le chipset d’un iPhone ? Mettre un réveil et un minuteur? Pour de la correction de texte, ce n’est pas toujours si simple en local.

Je n’ai pas encore vu Google nano mais cette idée de ai générative locale, ça me semble encore prématuré. Wait and see; mais j’ai l’impression qu’on sera un peu déçu de ce que pourront faire tourner nos iPhones avec 4go de ram. Ou alors ce sera réservé à l’iPhone Pro Max à 1500€ :/ Le tout pour des fonctions très limitées.

Ne pas mal me comprendre : j’ai très envie d’être bluffé par Apple sur ce sujet. Et Apple m’a bluffé quand ils ont sorti le M1.

@lienmathieu2

Il y a un énorme potentiel de simplification de l’interface homme machine avec un assistant qui comprend mieux ce qu’on lui demande, et ça a pour des raisons de fluidité beaucoup d’intérêt à être traité en local

Je pense que chez Apple, ils se creusent la tête pour savoir quelle profondeur de gamme ils devront faire sur l’AI locale: 2, 3 ? (sans, nano, moyenne), et avec quelle puissance; sachant que le top sera dans le Cloud, et qu’on aura certainement un abonnement pour la famille, chez Apple ou ailleurs.

Mais je les vois pas se priver du bénéfice marketing et financier consistant à vendre un produit très cher avec le truc le plus puissant qu’ils peuvent.

@hugome

« Mais je les vois pas se priver du bénéfice marketing et financier consistant à vendre un produit très cher avec le truc le plus puissant qu’ils peuvent. »

Je comprends mais ça semble un peu un dilemme à l’envers : le smartphone le plus puissant au monde n’arrive pas à la cheville des gpu dédiés d’un datacenter équipé ia. Du coup on paiera à prix d’or un appareil qui n’arrive pas à la cheville du cloud.

La latence input /output des LLM ‘cloud’ est quelque chose qui va s’améliorer. (Quand on voit comment on fait tourner des jeux gourmands en Cloud Gaming avec des latences de contrôle de plus en plus imperceptibles).

Et enfin, le dernier argument « vie privée » du local me semble largement exagéré : on ne parle pas d’un processus d’identification tel Touch ID ou Face ID (qui sont stockés localement); on parle d’un algorithme personnalisé selon les usages de l’utilisateur. Cela m’étonnerait qu’on refuse de faire un backup iCloud si on perd son téléphone et repasser des semaines à entraîner son LLM personnalisé. Quid des connexions avec des services musicaux ? À une app de gestion de notes? Tout ceci est impossible dans du « pur local »

@lienmathieu2

On peut voir le sujet différemment:

- Est-ce que Apple va essayer de faire de l’IA locale ?

Je n’ai aucun doute là-dessus. Le hardware est leur ADN, la source de leur marge astronomique, ils ont un track record avec l’Apple Silicium, c’est valorisé par la bourse (nvidia), ils ont déjà commencé avec leur Neural Engine qui est pourtant aujourd’hui inexploité, et c’est une promesse séduisante pour les développeurs

- Est-ce qu’il vont le vendre cher ?

Pareil. D’une part ça coûte, et quand on connaît Apple…

- Est-ce que cette stratégie est gagnante et crédible?

C’est là aussi un point fort d’Apple, d’arriver à convaincre que leurs produits sont indispensables et meilleurs qu’ailleurs. Alors même que c’était indiscutable pendant des décennies, c’est aujourd’hui discutable et pourtant on n’a jamais autant acheté Apple.

Je m’inquiète pas trop sur ça.

De toute façon, il est probable qu’on n’aura pas trop le choix, on peut pas acheter un iPhone sur mesure.

- Est-ce que ça sera une solution meilleure qu’une solution distante ?

Ben pas forcément, comme tu le dis.

D’abord, j’insiste parce qu’il semblerait que certains aient encore des doutes, il ne sera JAMAIS possible de faire aussi puissant sur un smartphone que sur un serveur partagé que l’on utilise que quelques fois par jour mais qui peut se permettre d’être mille fois plus puissant

Donc l’IA la plus intelligente, elle ne sera pas locale.

Je ne crois pas non plus que la privacy soit un réel argument.

Par contre la disponibilité des données en local indexées en temps réel avec un moteur neuronal entraîné régulièrement (la nuit par exemple), accessible aux développeurs tiers, ça c’est un argument.

Donc l’enjeu d’Apple n’est pas d’être le meilleur, ils ont déjà perdu, et l’exemple de Google Search et Maps, de Siri, Alexa etc sont là pour prouver que côté services, ils ne sont pas les rois du monde.

Leur enjeu c’est de rester les vendeurs d’un smartphone premium que les gens ont envie d’acheter.

Et là dessus, s’ils sont pas trop couillons y a aucune raison qu’ils y arrivent pas en proposant un Siri qui fait un job honnête.