On a essayé Bard, la réponse de Google à ChatGPT

Ça va Barder ! Sous la pression d'OpenAI et de Microsoft, Google vient de lancer en bêta son concurrent à ChatGPT. Pour le moment, Bard est accessible uniquement sur invitation aux États-Unis et au Royaume-Uni, mais nous avons d'ores et déjà pu l'essayer1.

Autant le dire tout de suite : l'intérêt de ce nouveau robot conversationnel est pour l'instant relativement limité pour nous autres Français car il ne gère principalement que l'anglais. Néanmoins, on peut d'ores et déjà constater que Google a fait des choix assez différents d'OpenAI sur certains points.

Un robot averti en vaut deux

Avant de papoter (en anglais) avec Bard, il faut donc avoir reçu une invitation. Dans notre cas, elle nous a été délivrée seulement deux jours après notre demande, mais le délai est variable car Google ouvre progressivement les vannes. À noter aussi qu'un compte Google est indispensable pour accéder au service.

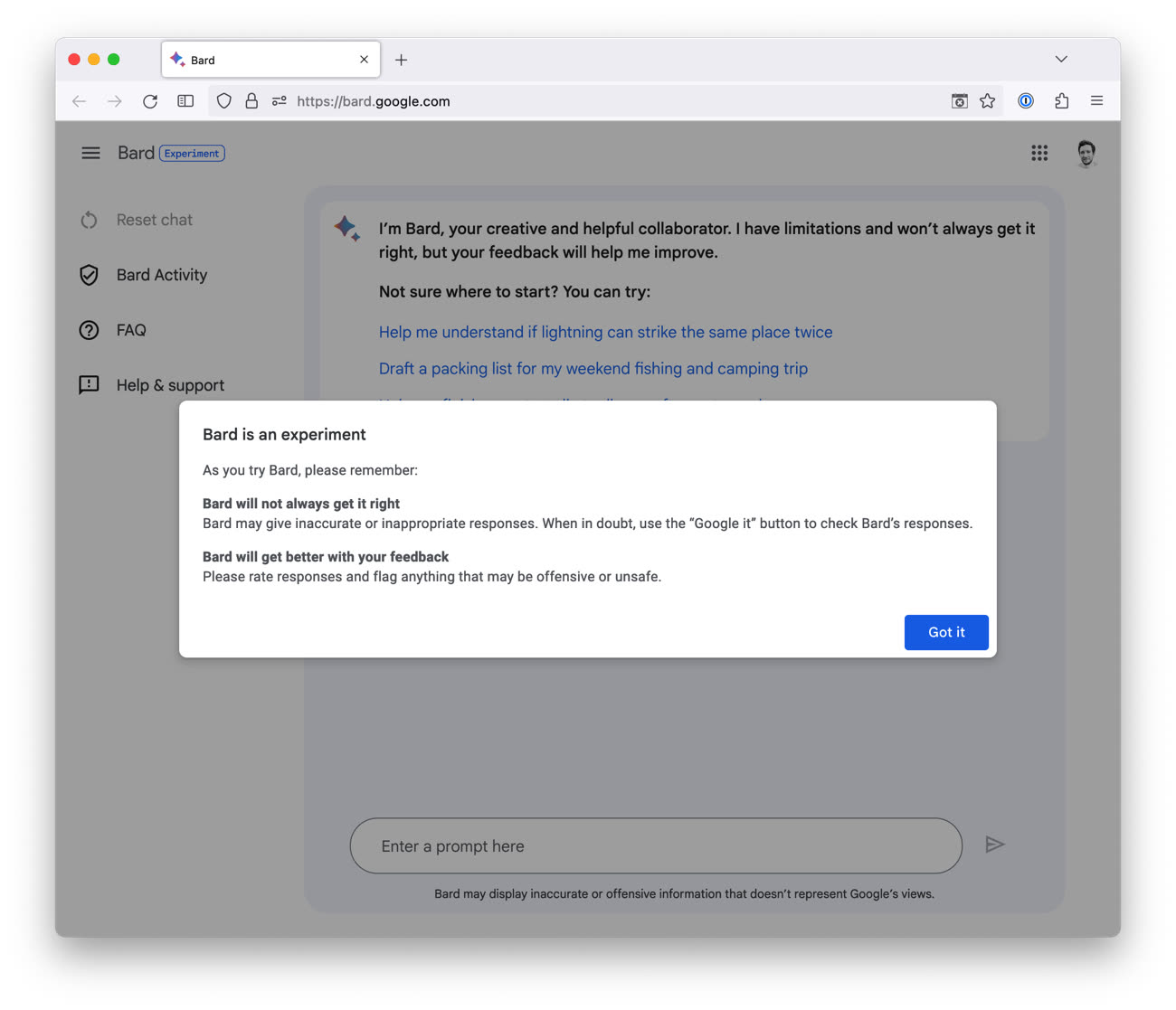

Lors de la première connexion, plusieurs choses essentielles sur le plan de la confidentialité sont indiquées : les conversations avec Bard sont enregistrées et elles peuvent être lues et annotées par des humains afin d'améliorer le service. Cela changera peut-être un jour, quand Bard ne sera plus considéré comme expérimental, mais en attendant il faut avoir conscience que tout ce qui est partagé avec le robot peut être lu par une personne en chair et en os — OpenAI fait pareil avec ChatGPT. C'est la raison pour laquelle Google demande de ne saisir aucune information personnelle.

Après avoir accepté les conditions d'utilisation habituelles de Google ainsi que des conditions supplémentaires liées à l'IA générative (qui demandent d'avoir 18 ans minimum et qui interdisent de se servir de Bard pour développer des technologies d'intelligence artificielle), on a droit à un message d'avertissement qui précise que Bard est une expérimentation, qu'il peut faire des erreurs et que les retours sont importants pour l'améliorer.

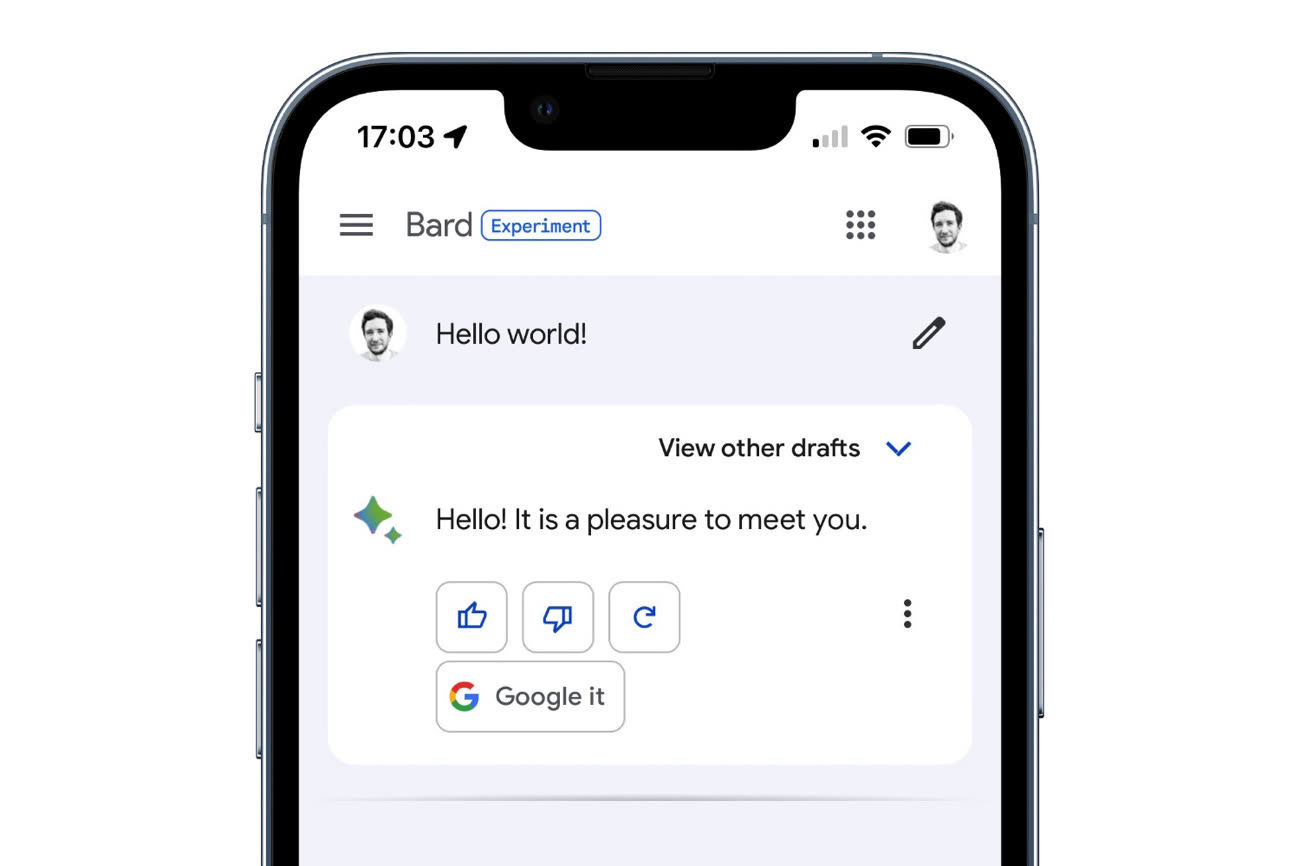

Ces avertissements, Google les réitère ensuite à plusieurs endroits : badge « Experiment » en haut à gauche, phrase d'intro de Bard qui présente ses limites et mention sous le champ de saisi qui précise que les réponses ne représentent pas forcément les opinions de l'entreprise.

Si OpenAI prévient aussi que ChatGPT n'est pas parfait, Google prend encore plus de pincettes avec Bard. Pourquoi ? Parce que les deux entreprises ne sont pas dans la même position. Tandis qu'OpenAI est un outsider qui n'a rien à perdre, Google est une multinationale ultra puissante scrutée par tous les régulateurs. Et puis Bard arrive après ChatGPT, qui est devenu par la force des choses la référence des agents conversationnels. Pour ne pas écorner son image, Google doit donc entourer son robot de multiples précautions.

« Google demande de ne saisir aucune information personnelle. »

Cette phrase n’a aucun sens 😄

Par contre la finale 98, quand je lis 1-1 au score, je me dit que Siri ferait mieux… et c’est fou de dire ça 😄

Stéphane, fan de Philippe Katerine ? 😉

@Manu9

🥏Miel De Montagne - C’est Dur 🎸

J’ai toujours la même impression : ça sort un baratin spectaculaire, mais justement un baratin, avec beaucoup de conneries. Un outil génial pour s’aider dans l’écriture d’une lettre, un outil calamiteux et dangereux dès qu’on a besoin d’une réponse avec des faits…

@Furious Angel

Un baratin... Oui et non. Il ressort (plutôt bien) un baratin fondé sur ce qu'il a appris. D'où le problème fondamental de tous ces trucs : la réponse va dépendre du lot d'apprentissage. Qui est évidemment facilement et fondamentalement manipulable. Supposons que ChatGPT & Co soient accessibles en Chine. Demandez-lui à quoi Tien an Men lui fait penser. À votre avis?

@zoubi2

Je ne sais pas si c’est aussi simple que ça.

Évidemment, ces robots ne peuvent donner des informations qu’à partir de ce qui les a alimentés, et si on ne leur a pas données les infos sur Tienanmen, ils ne pourront pas les ressortir.

Mais ce qui fait que les réponses d’un être humain restent pour le moment supérieures (encore que ça dépend ; si on s’adresse à un complotiste, c’est croustillant), c’est que le cerveau humain vérifie en permanence si ses raisonnements sont cohérents. S’ils sont crédibles. S’ils sont logique.

Exemple (vécu il y a quelques minutes avec ma fille) : si on vous montre une photo de 2 tortues, l’une étant étiquetée comme ayant 8 ans et l’autre 7 mois, et si visuellement ces 2 tortues semblent avoir le même âge, vous allez tout de suite tiquer. Car il y a un manque de cohérence entre ces 2 informations.

L’IA en revanche va s’appuyer bêtement sur ce qu’il a ingurgité sans chercher une cohérence culturelle.

Je pense que ce mécanisme de recherche de cohérence ou de logique des informations est fondamental pour ne pas sortir des faussetés. Et je pense que les IA en sont actuellement incapables.

J’ai testé pour voir. En 3 ou 4 questions simples, ChatGPT m’a donné une information fausse.

Y’a encore du boulot…

J’ajoute que ces technologies sont très excitantes, mais il le semble que pour bien en tirer partie, il faudra avoir une bonne culture générale et une bonne capacité d’analyse de cohérence et de logique.

@bozzo

« J’ajoute que ces technologies sont très excitantes, mais il le semble que pour bien en tirer partie, il faudra avoir une bonne culture générale et une bonne capacité d’analyse de cohérence et de logique »

C’est tout à fait ça dans une démarche de rechercher généraliste. Et quand on lui fait faire un travail spécifique dans un domaine spécifique, on peut gagner énormément de temps mais il faut déjà être capable de faire ce travail soi-même pour éviter les grosses bourdes.

Demandez lui d’analyser la fonction grammaticale des mots d’une phrase. Il saura le faire et fera gagner beaucoup de temps mais il fera une erreur de temps en temps que l’expert humain n’aura plus qu’à corriger manuellement.

De même il peut générer du code mais il faut au moins savoir lire ce code pour s’assurer qu’il fonctionne comme attendu. Cela fait gagner du temps (parfois énormément) mais ça ne fait pas tout.

@zoubi2

Ça me fait penser au compte Twitter géré par une IA de Microsoft, qui apprenait en fonction des réponses à ses tweets qu’elle avait, et qui est finalement devenue néo-nazie en quelques heures seulement. Ils ont vite fait machine arrière. Si les devs ont un bon contrôle sur ça, il sera pas évident de les faire aussi mal tourner.

@zoubi2

« Un baratin... Oui et non. Il ressort (plutôt bien) un baratin fondé sur ce qu'il a appris. D'où le problème fondamental de tous ces trucs : la réponse va dépendre du lot d'apprentissage. »

Mais justement on voit qu’il dit n’importe quoi sur le score de France-Brésil 98, qui est pourtant une info facile à trouver et extrêmement documentée…

@Furious Angel

Ce type de modèle n’est pas conçu pour générer des suites de texte « vraies » mais « probables ». Pour cette raison si l’on cherche une information précise, le recours à chatGPT ou Bard n’est (pour le moment) pas pertinent. Ou alors utiliser Bing qui cite ses sources où il faut toutefois faire l’effort de se rendre pour vérifier l’information.

Salut,

Pas encore lu l'article, par contre je viens de voir une vidéo Underscore_ de Micode assez intéressante.

Il est possible de mettre une IA dans son Mac Silicon !?!

Vu sur YouTube : "Pourquoi ChatGPT vient de se faire détrôner"…

@Manuko

+1